Jak Google ocenia wartość linków? 20 przykładów na to, że link linkowi nierówny

Na moz.com opublikowany został artykuł, który przedstawia, w jaki sposób rozdzielana jest moc linków umieszczonych na stronie. Uznaliśmy, że warto przełożyć tę treść na język polski i tym samym sprawić, że kompendium wiedzy o przepływie PageRank pomiędzy stronami połączonymi linkami, będzie zrozumiałe dla wszystkich. Poniżej znajduje się przekład artykułu „All Links are Not Created Equal: 20 New Graphics on Google’s Valuation of Links”, czyli: „Link linkowi nie równy: 20 infografik, jak Google podchodzi do poszczególnych rodzajów linków”. Zapraszamy do lektury!

W 1998 r. Larry Page i Sergey Brin, założyciele Google, stworzyli algorytm PageRank, czyli innymi słowy „metodę nadawania indeksowanym przez wyszukiwarkę stronom internetowym określonej wartości liczbowej, oznaczającej ich jakość” (definicja według Wikipedii). W dużym uproszczeniu oznaczało to, że algorytm oceniał jakość strony na podstawie liczby prowadzących do niej linków.

Wtedy też najwyższą wartość PageRank osiągały strony z największą liczbą linków zwrotnych. Z czasem ocenie została poddana jednak również ich jakość. W praktyce oznaczało to, że jeśli witryna posiadała linki z mocnych stron, czyli z takich, do których prowadziło wcześniej wiele wartościowych linków, otrzymywała wyższy PageRank. I analogicznie – jeśli linki prowadziły głównie z mało popularnych witryn, wartość strony docelowej była niższa.

Po pewnym czasie zaszło sporo zmian w ocenie wartości strony i przekazywaniu PageRank pomiędzy nimi. Dziś jest to dużo bardziej skomplikowane i znacznie odbiega od pierwotnych założeń. Podczas przekazywania PageRank mają znaczenie między innymi takie aspekty jak:

- tekst zakotwiczenia (anchor),

- sama jakość treści na podstronie/domenie, gdzie został umieszczony link,

- widoczność i liczba ruchu na stronie, z którego pochodzi odnośnik,

- zachowanie użytkowników trafiających na tę stronę (czy angażują się w przeglądanie zawartości czy opuszczają stronę).

Według Google wszystkie zmiany miały zapewnić użytkownikom większą wygodę i lepsze wyniki wyszukiwania, a w praktyce, ograniczyć do minimum spam oraz manipulowanie wynikami wyszukiwania poprzez kupno lub sprzedaż linków na portalach stworzonych wyłącznie w tym celu.

Poniżej przedstawiamy 20 infografik z przykładami oceny jakości i mocy linków przez algorytm PageRank, które zostały zaobserwowane przez SEO-wców na całym świecie. Niektóre z nich zostały potwierdzone przez Google, a niektóre opatentowane.

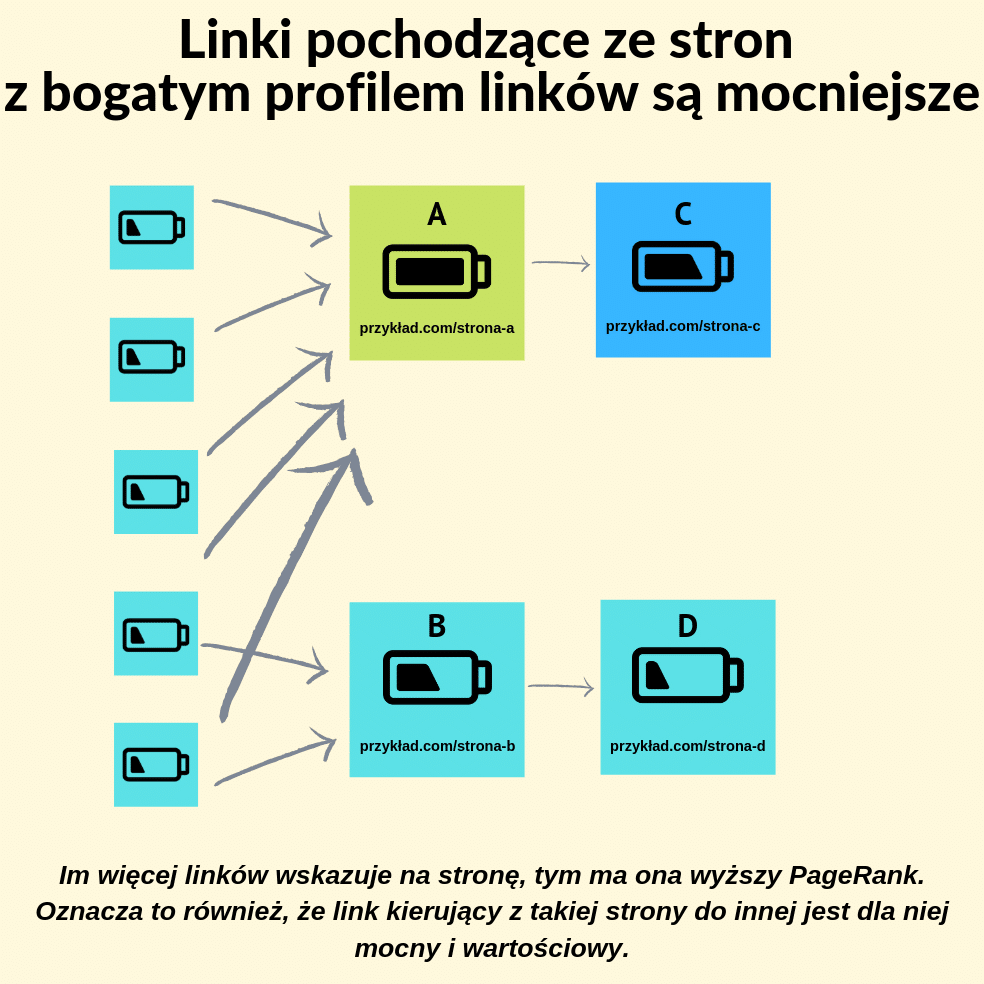

1. Linki pochodzące ze stron z bogatym profilem linków są mocniejsze

To podstawowa zasada, według której można przyjąć, że im więcej linków prowadzi na daną stronę z innych witryn, tym wyższy ma ona PageRank. A im wyższy PageRank, tym więcej może go przekazać innym stronom za pomocą linków wychodzących.

Pozyskanie linku z popularnej strony daje zazwyczaj lepszy efekt, aniżeli zdobycie linku ze strony mającej ubogi profil linkowy.

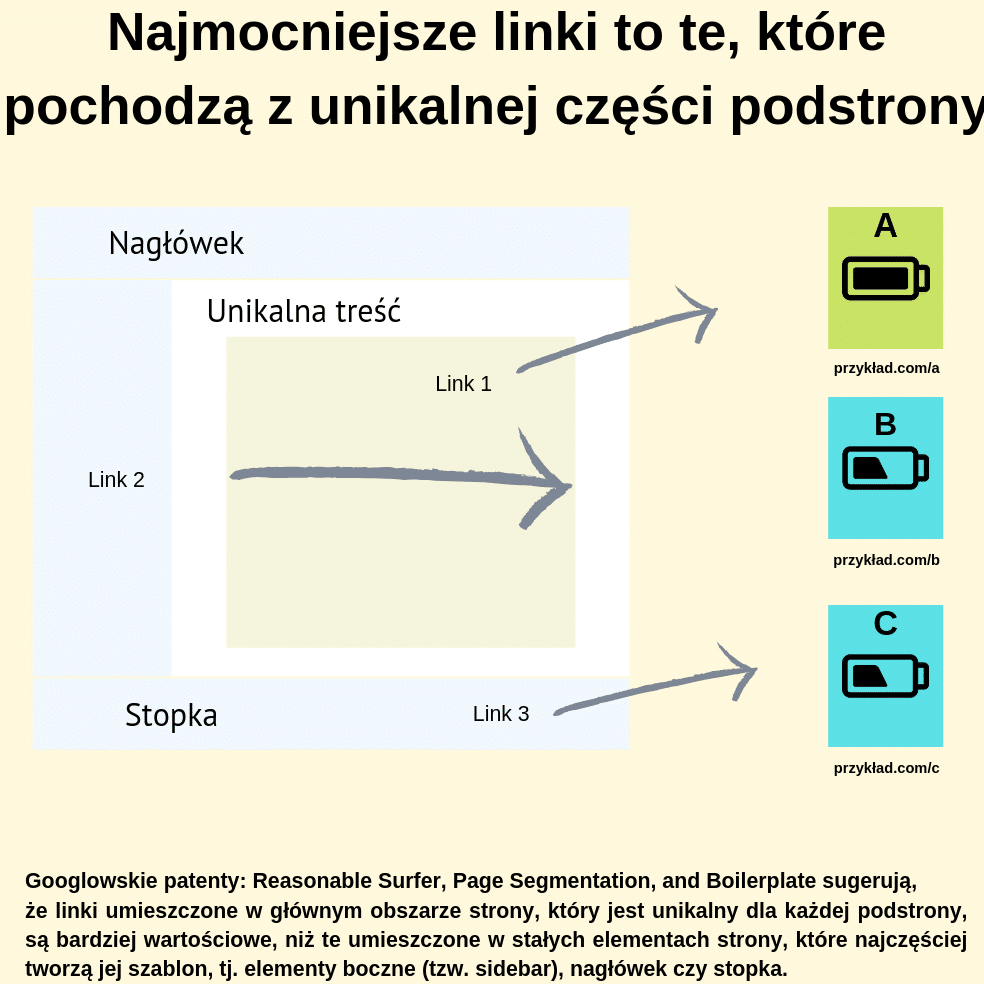

2. Najmocniejsze linki to te, które pochodzą z unikalnej części podstrony

Wszystkie patenty Google sugerują, że linki umieszczone w głównym obszarze strony, który jest unikalny dla każdej podstrony, czyli np. w unikalnym fragmencie treści, są bardziej wartościowe, niż te umieszczone w stałych elementach witryny, które najczęściej składają się na jej szablon, takich jak:

- elementy boczne (tzw. sidebar),

- nagłówek,

- stopka.

Wydaje się być to logiczne, bowiem dodając treść na stronę z chęcią dodania odnośnika np. do źródła, naturalnym jest, że umieścimy go w tej właśnie treści. Dodanie linków w stałych elementach strony wymaga najczęściej głębszej ingerencji w CMS, a nie jest to często spotykaną praktyką.

Nawet w wytycznych dla raterów Google zachęca, aby podczas oceny podstrony skupiali się oni na głównej jej części, czyli niejako pomijali inne elementy szablonu.

Mimo wszystko Google twierdzi, że indeksuje wszystkie linki znalezione na danej stronie. W praktyce jednak – według testów SEO-wców – te linki, które są umieszczone pod rozwijalnymi kartami lub akordeonami (np. “czytaj więcej”) przekazują mniejszą moc.

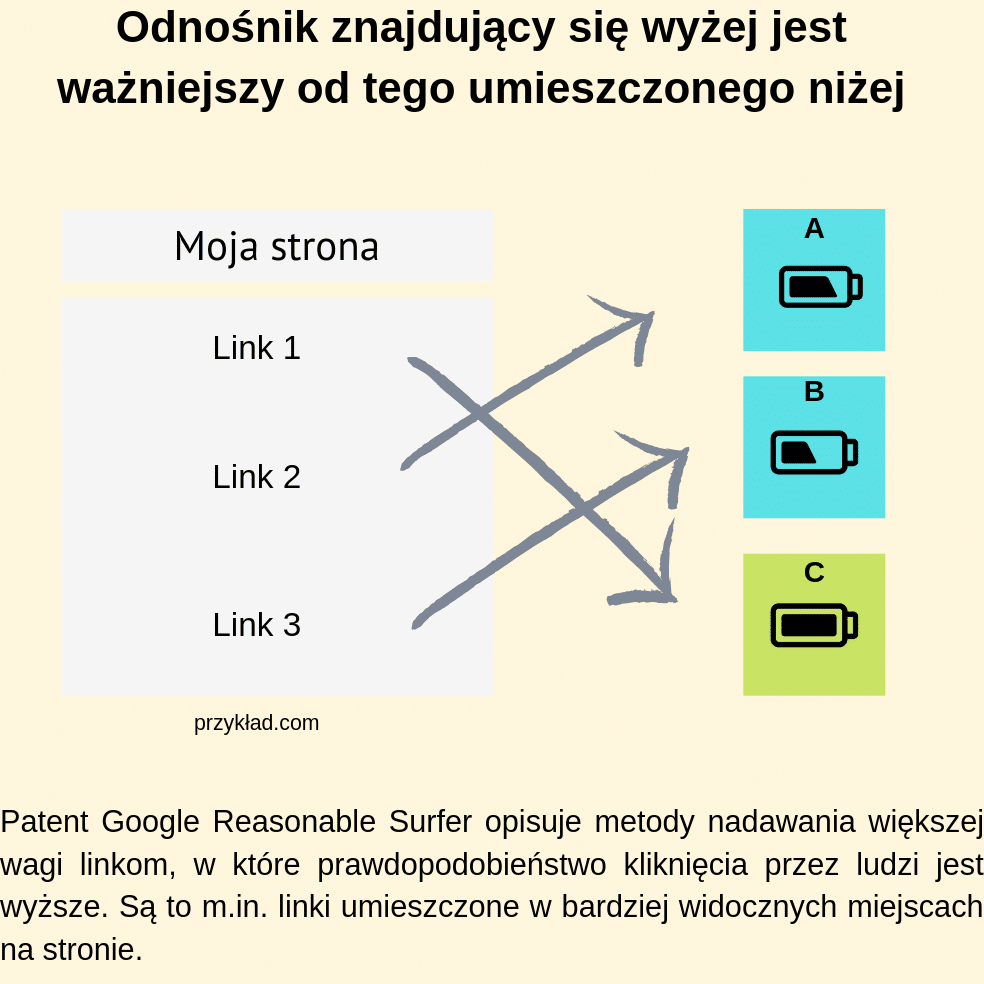

3. Odnośnik znajdujący się wyżej jest ważniejszy od tego umieszczonego niżej

Patent Google Reasonable Surfer opisuje metody nadawania większej wagi linkom, które według nich będą klikane – w tym linki umieszczone w bardziej widocznych miejscach na stronie. Prawdopodobieństwo, że klikniemy w pierwszy, a nie drugi czy trzeci napotkany link, jest zdecydowanie większe. W 2010 roku potwierdził to Matt Cutts (były szef zespołu Google do walki ze spamem), który dodatkowo zachęcał, aby ważne linki umieszczać możliwie jak najwyżej.

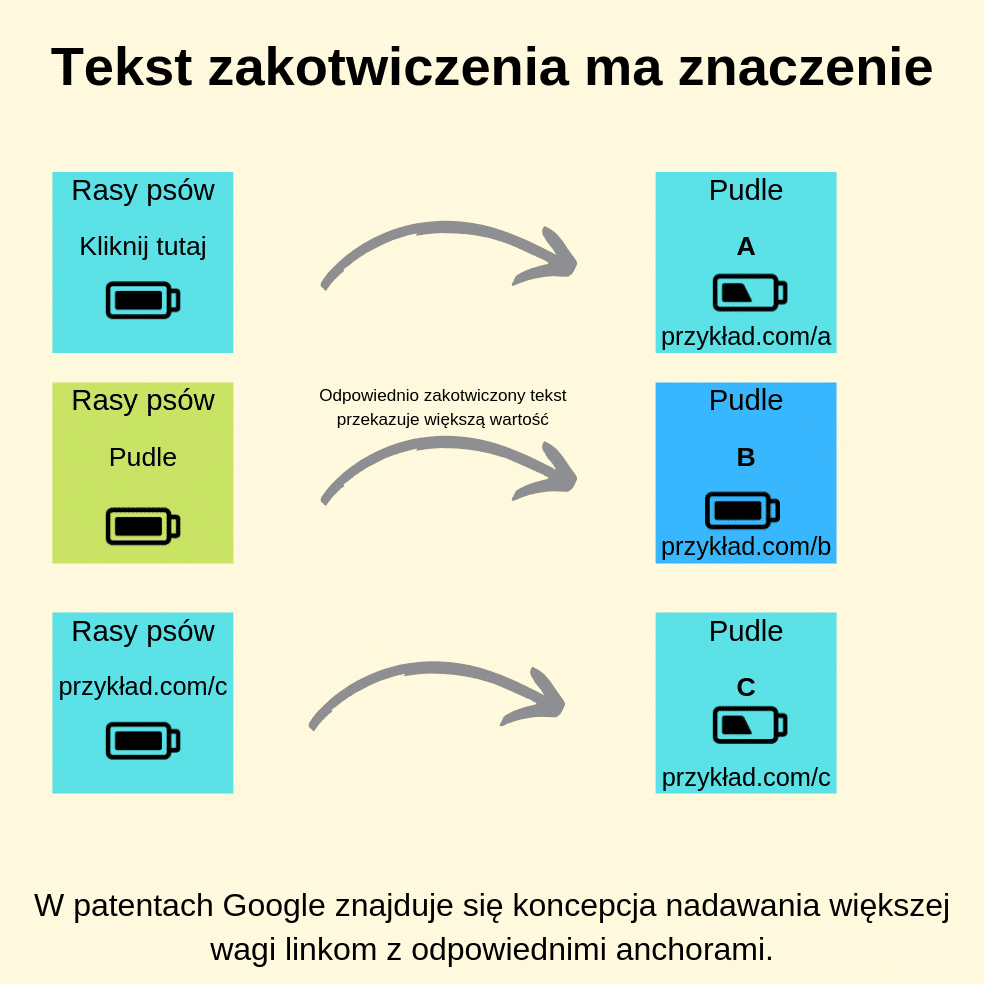

4. Tekst zakotwiczenia ma znaczenie

Tego punktu chyba nie trzeba szczególnie opisywać – każdy, kto choć trochę orientuje się w branży SEO wie, że treść linka ma znaczenie. Wiadomym jest, że link typu “kliknij tutaj” przekaże mniej mocy (lub wcale) niż link zawierający tekst zakotwiczenia w dopasowaniu ścisłym (exact-match), czyli “pozycjonowanie stron”.

Tutaj ważna uwaga – w patentach, które mówią o istotności tekstu zakotwiczenia, znajdują się również uwagi co do ignorowania anchorów linków niezwiązanych z tematem.

Ważnym jest, by pamiętać o dywersyfikacji anchorów, linkowaniu zarówno na exact-match, jak i odmiany tych fraz oraz sam adres URL. Grunt to zachować zdrowe proporcje i naturalną mieszankę tekstów zakotwiczenia w profilu linków domeny.

Wartym podkreślenia jest fakt, że linki mogą przenosić kontekst słów i zwrotów kluczowych znajdujących się wokół łącza. Jeśli więc treść, w której umieszczamy link jest mocno powiązana z tematem, na który chcemy być widoczni, pozostawienie linka innego niż w formie ścisłego dopasowania również przyniesie korzyść.

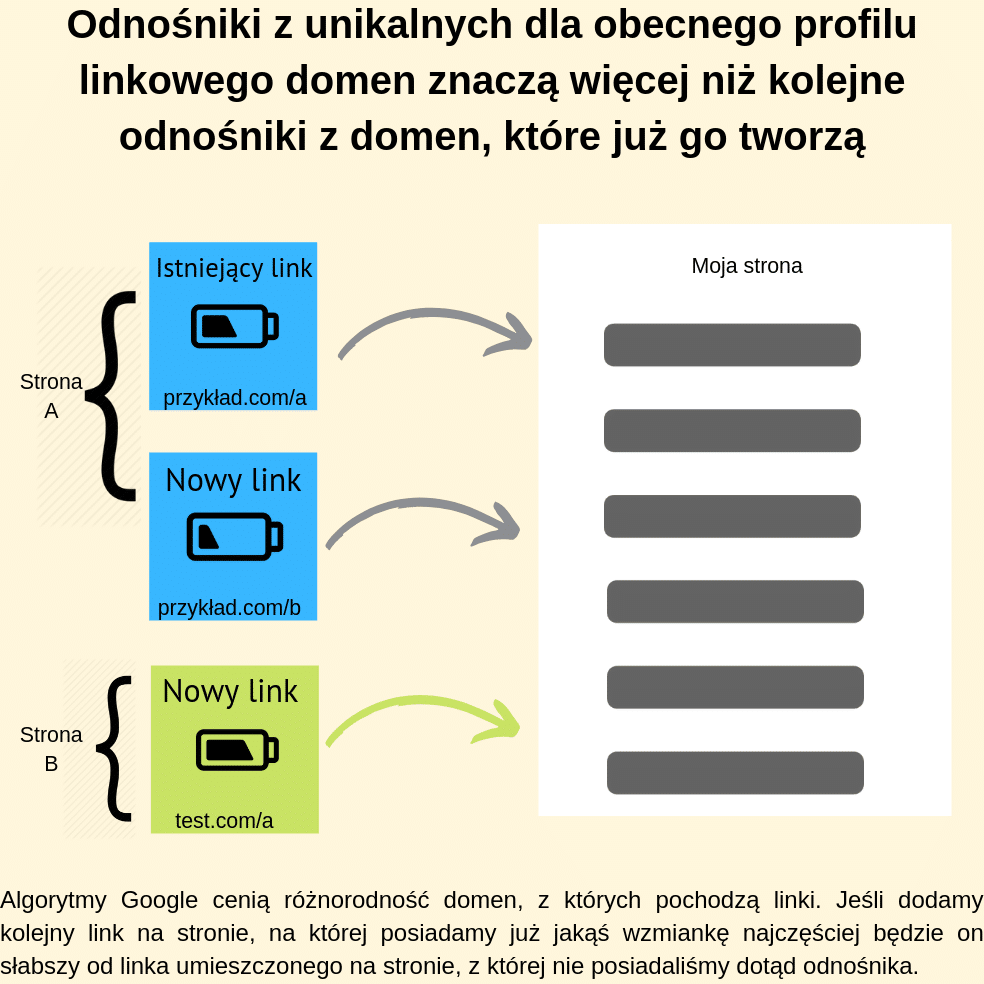

5. Odnośniki z unikalnych dla obecnego profilu linkowego domen znaczą więcej niż kolejne odnośniki z domen, które już go tworzą

Doświadczenie pokazuje, że lepiej jest mieć 50 linków z 50 różnych domen niż kolejne 500 linków z witryny, na której zdobyliśmy już odnośnik. Algorytmy Google są bowiem zaprojektowane tak, aby mierzyć popularność strony w całej sieci, a nie opierać się wyłącznie na sumarycznej liczbie linków. Niemal wszystkie testy wskazują, że mniejsza liczba linków pochodzących z większej liczby unikalnych domen daje lepsze wyniki niż większa liczba linków pochodzących z mniejszej liczby unikalnych domen.

Istnieją jednak pewne odstępstwa od tej zasady – warunkiem jest postawienie na szali mniej lub bardziej autoratywnej domeny. Jako przykład możemy wskazać domenę onet.pl oraz zupełnie nowy blog pod adresem domena-internetowa.pl. W tym przypadku korzystniej będzie dodać kolejny link na onet.pl i ponieważ przekaże zdecydowanie większą moc.

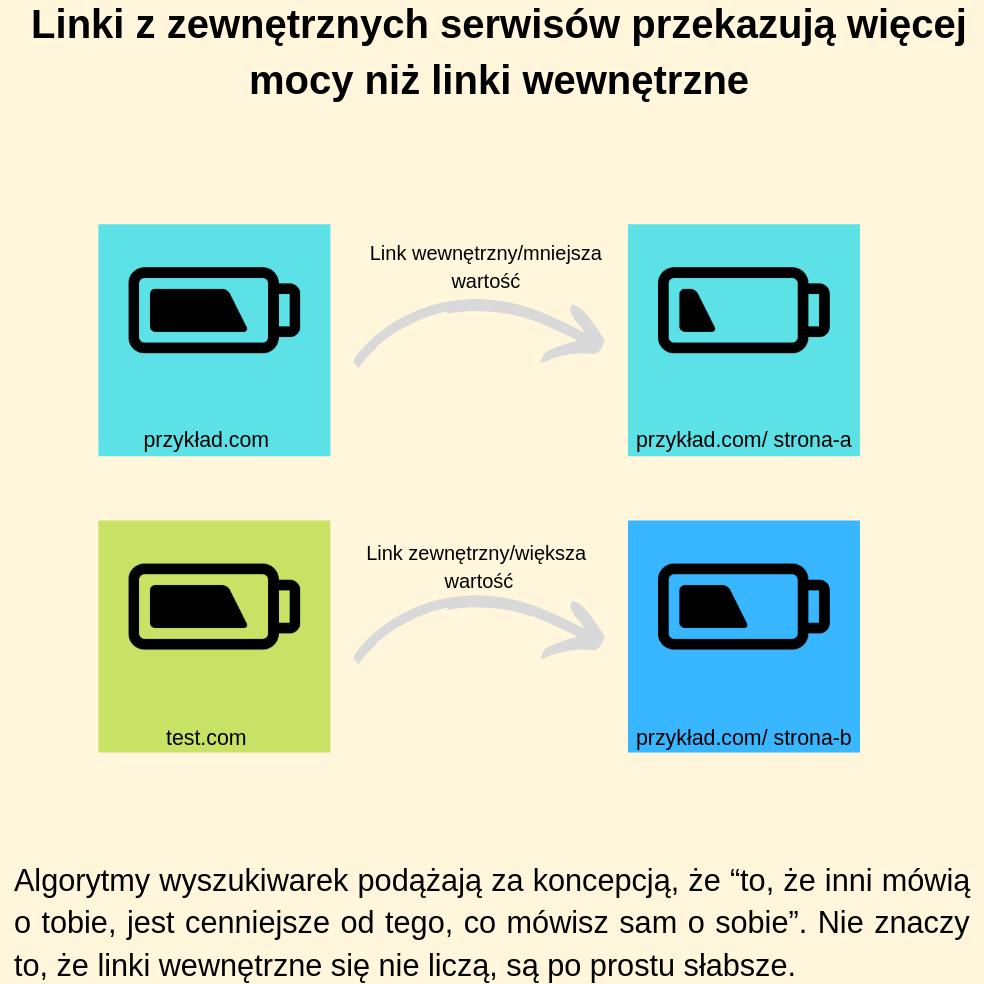

6. Linki z zewnętrznych serwisów przekazują więcej mocy niż linki wewnętrzne

Badania korelacji niemal zawsze pokazują, że witryny zajmujące wysokie pozycje są powiązane z dużą liczbą linków zewnętrznych. Algorytmy wyszukiwarek podążają za koncepcją, że “to, że inni mówią o tobie, jest cenniejsze od tego, co mówisz sam o sobie”. Nie znaczy to, że linki wewnętrzne się nie liczą. Wręcz przeciwnie, linki wewnętrzne i dobra architektura witryny mają również wpływ na ranking, ale to temat na osobny punkt.

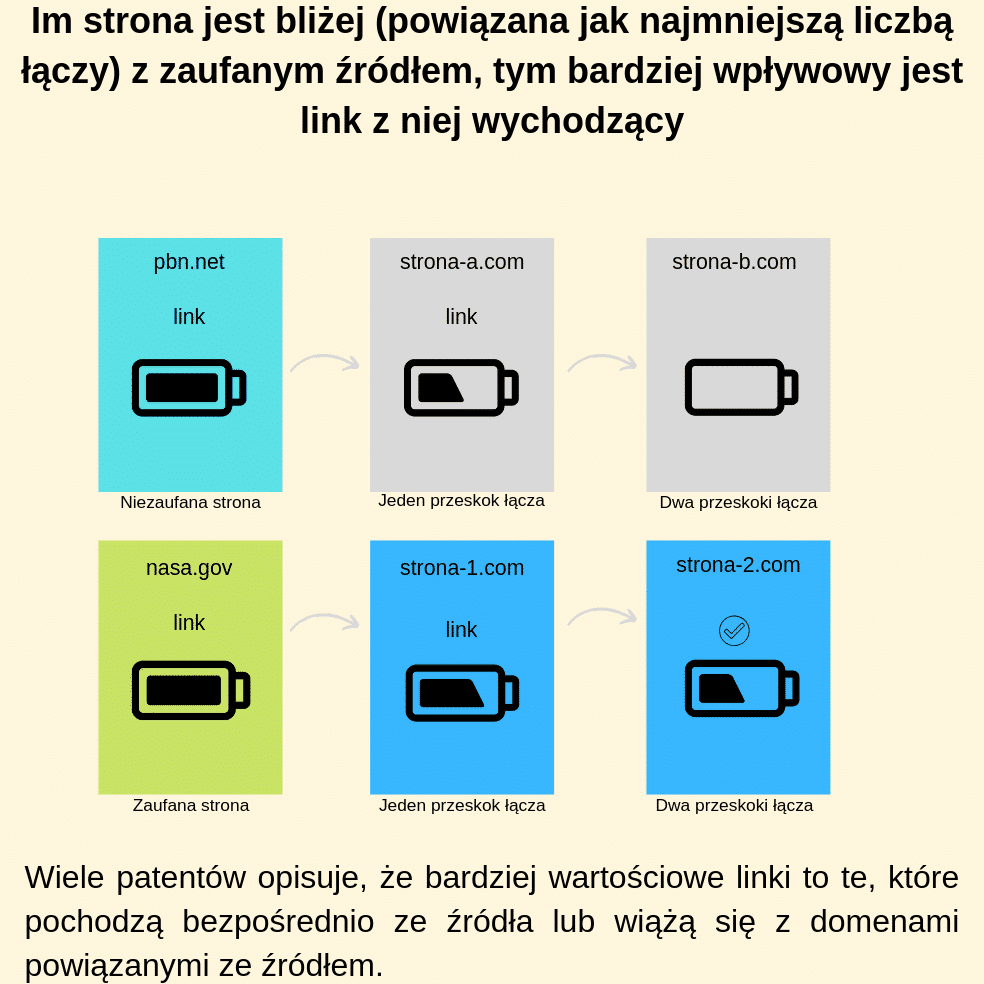

7. Im strona jest bliżej (powiązana jak najmniejszą liczbą łączy) z zaufanym źródłem, tym bardziej wpływowy jest link z niej wychodzący

Koncepcja TrustRank dotyczy każdej strony i określa poziom jej rzetelności. Im wyższy TrustRunk, tym większe prawdopodobieństwo, że jest to witryna, z której można czerpać wiedzę, wiadomości i na której można się wzorować. Witryny, takie jak Wikipedia czy uznane poradniki branżowe, mają wysoki TrustRank i są powszechnie uznane za wartościowe źródła wiedzy. Jeśli otrzymamy link z takiej witryny, będzie on dużo silniejszy i bardziej wzmocni naszą domenę niż link z witryny o niższym autorytecie.

Idąc krok dalej – czasami łatwiej jest zdobyć link ze strony, do której linkuje taka wartościowa domena. Warto wiedzieć, że taki link również będzie silniejszy od pozostałych. Jednak im więcej domen i im więcej przeskoków, tym moc linku będzie spadać.

Najbardziej wartościowe są więc bezpośrednie linki z witryny zaufanej lub linki z witryny, z którą bezpośrednio wiąże się taka zaufana strona.

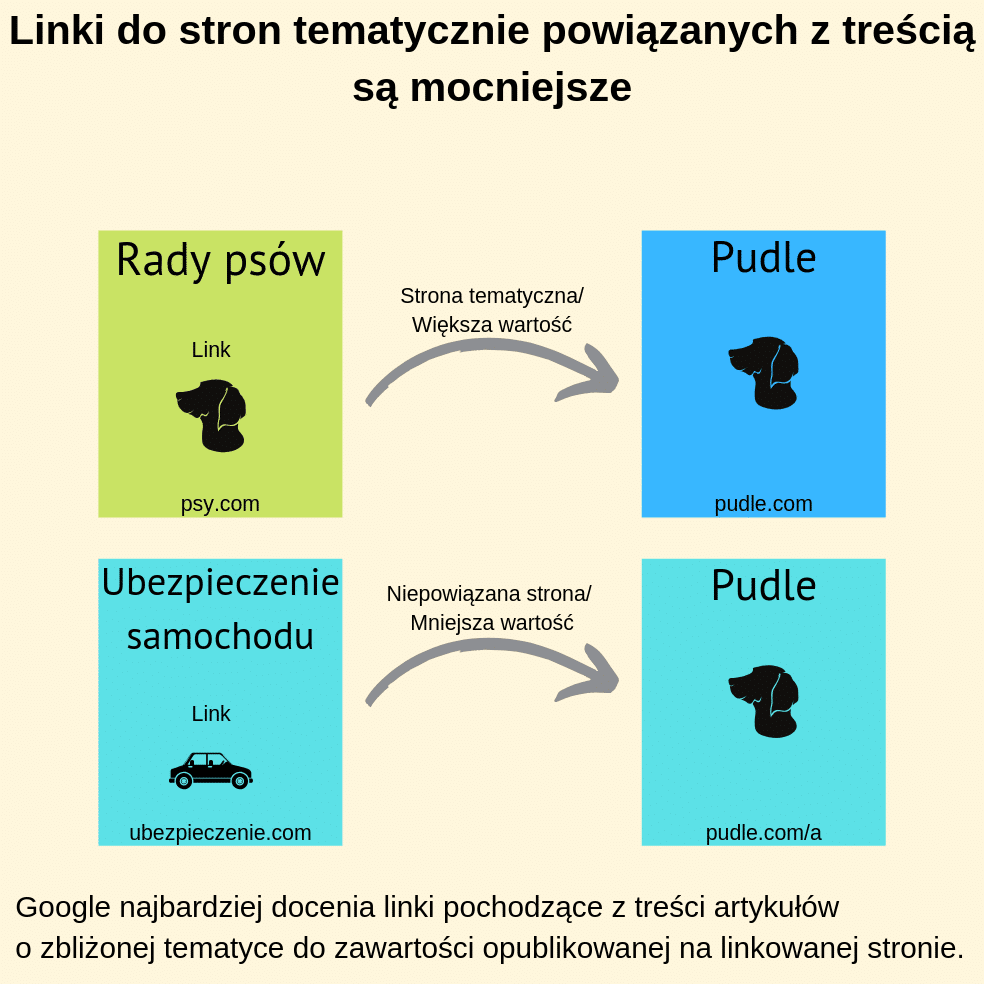

8. Linki do stron tematycznie powiązanych z treścią są mocniejsze

Wyobraźmy sobie, że pozycjonujesz stronę warsztatu samochodowego. Jako że linki można zdobywać z różnych miejsc, mamy do wyboru portal motoryzacyjny lub blog modowy. W tej sytuacji link pochodzący z artykułu dotyczącego wyboru warsztatu czy porad odnośnie serwisowania samochodów przekaże zdecydowanie więcej mocy stronie docelowej, aniżeli zupełnie przypadkowo wstawiony link na blogu modowym.

Podobna zasada obowiązuje podczas pozycjonowania strony na wyrażenia lokalne – chcąc zadbać o wysoką widoczność w danym regionie, lepiej jest publikować linki na lokalnych portalach, aniżeli niepowiązanych z żadną interesującą nas lokalizacją.

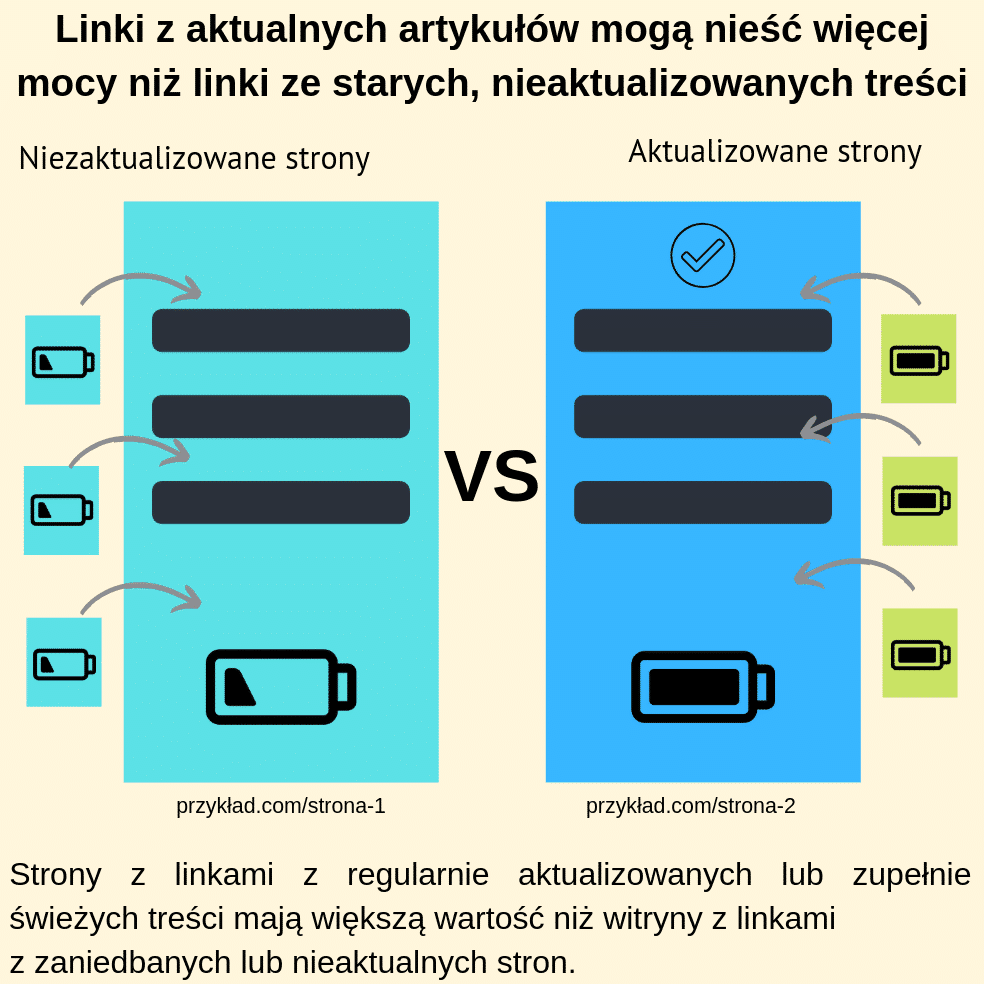

9. Linki z aktualnych artykułów mogą nieść więcej mocy niż linki ze starych, nieaktualizowanych treści

Google chce wyświetlać zawsze aktualne dane, więc promuje najnowsze treści. Koncepcja zakłada, że witryny z linkami pochodzącymi ze stron, które “żyją” – na przykład stale publikują nowe treści lub regularnie je aktualizują, mogą zajmować lepsze pozycje niż strony, do których większość linków prowadzi z nieaktualizowanych witryn.

W tym miejscu warto rozróżnić dwa pojęcia – domeny “stare”, ale nadal pozostające eksperckimi z aktualnymi i zadowalającymi użytkowników treściami oraz domeny “nieświeże”. Te drugie:

- nie były dawno aktualizowane,

- nie zdobywają nowych linków z innych stron,

- nie dostarczają użytkownikom odpowiedzi na ich pytania.

Należy pamiętać, że linki pochodzące z domen “starych” są znacznie cenniejsze od linków pochodzących z domen “nieświeżych”.

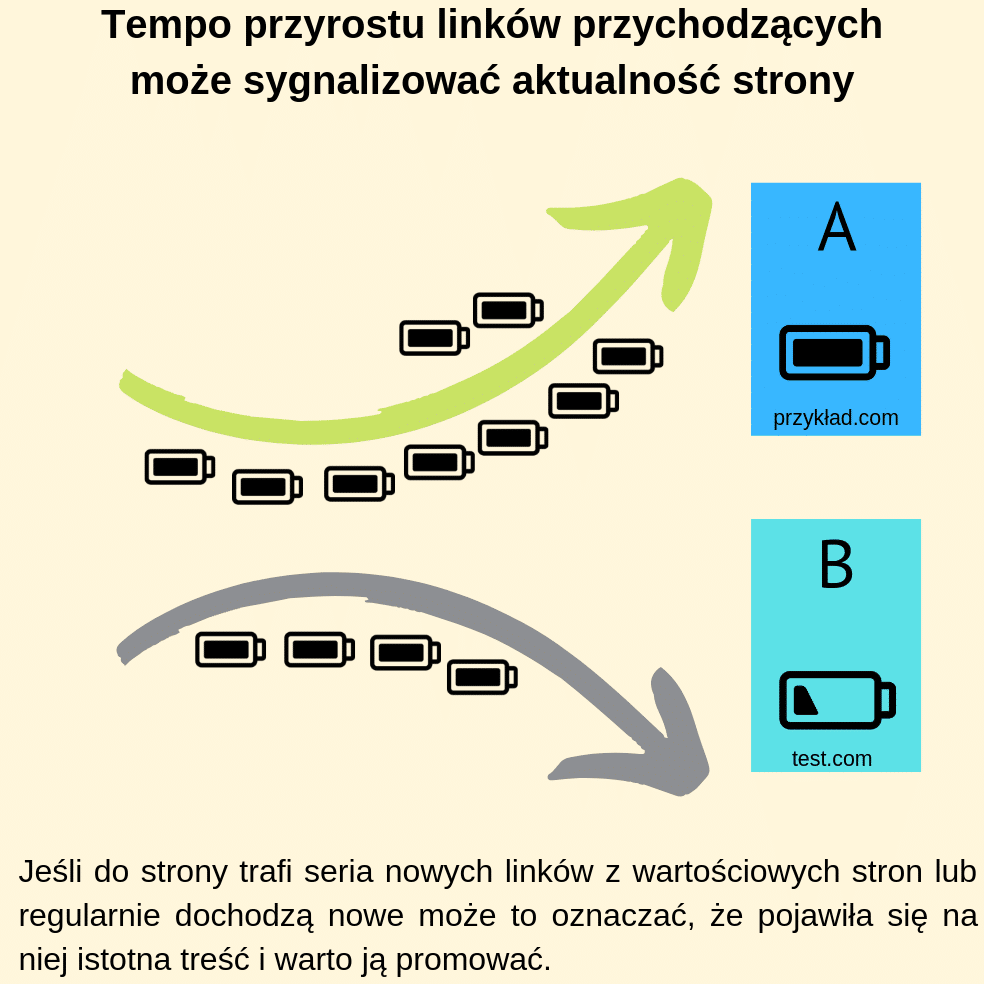

10. Tempo przyrostu linków przychodzących może sygnalizować aktualność strony

Jeśli tempo przyrostu nowych linków znacząco spadnie, może to oznaczać, że treści na stronie przestały być aktualne. W efekcie może to doprowadzić do obniżenia pozycji w wyszukiwarce.

Wskazane koncepcje objęte zostały patentem Google Information Retrieval, który opisuje analizę danych historycznych.

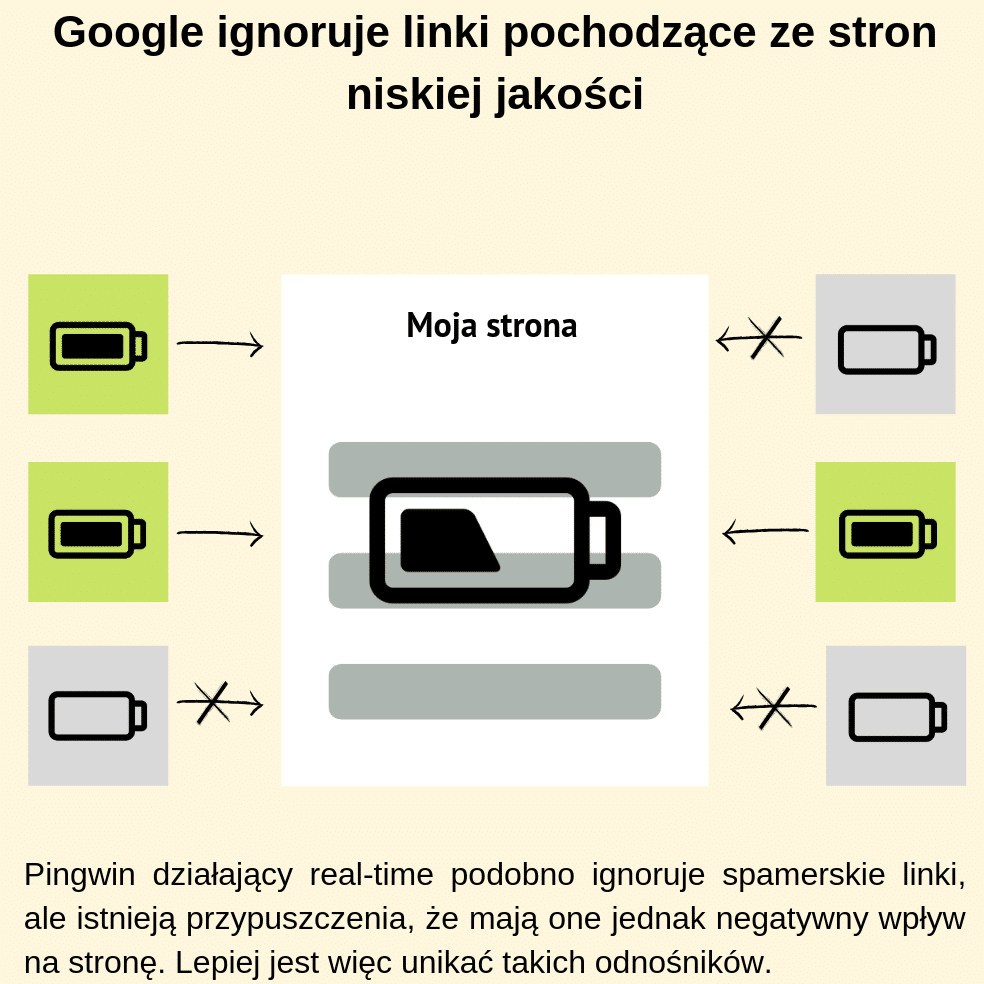

11. Google ignoruje linki pochodzące ze stron niskiej jakości

Dla Google najcenniejsze są linki opublikowane w wyniku naturalnych działań użytkowników, którzy chcą dzielić się wartościowymi treściami czy sprawdzonymi ofertami. Od momentu wypuszczenia algorytmu Pingwin 4.0 w 2016 roku Google na bieżąco ocenia jakość linków prowadzących do strony i zwyczajnie pomija te, które wyglądają na nienaturalne.

Warto wiedzieć, że pomimo zapewnień, iż spamerskie linki są ignorowane, istnieją przypuszczenia, że jednak mogą one wpływać negatywnie na stronę. Najlepiej więc unikać pozyskiwania linków ze stron stworzonych wyłącznie w celu publikacji odnośników.

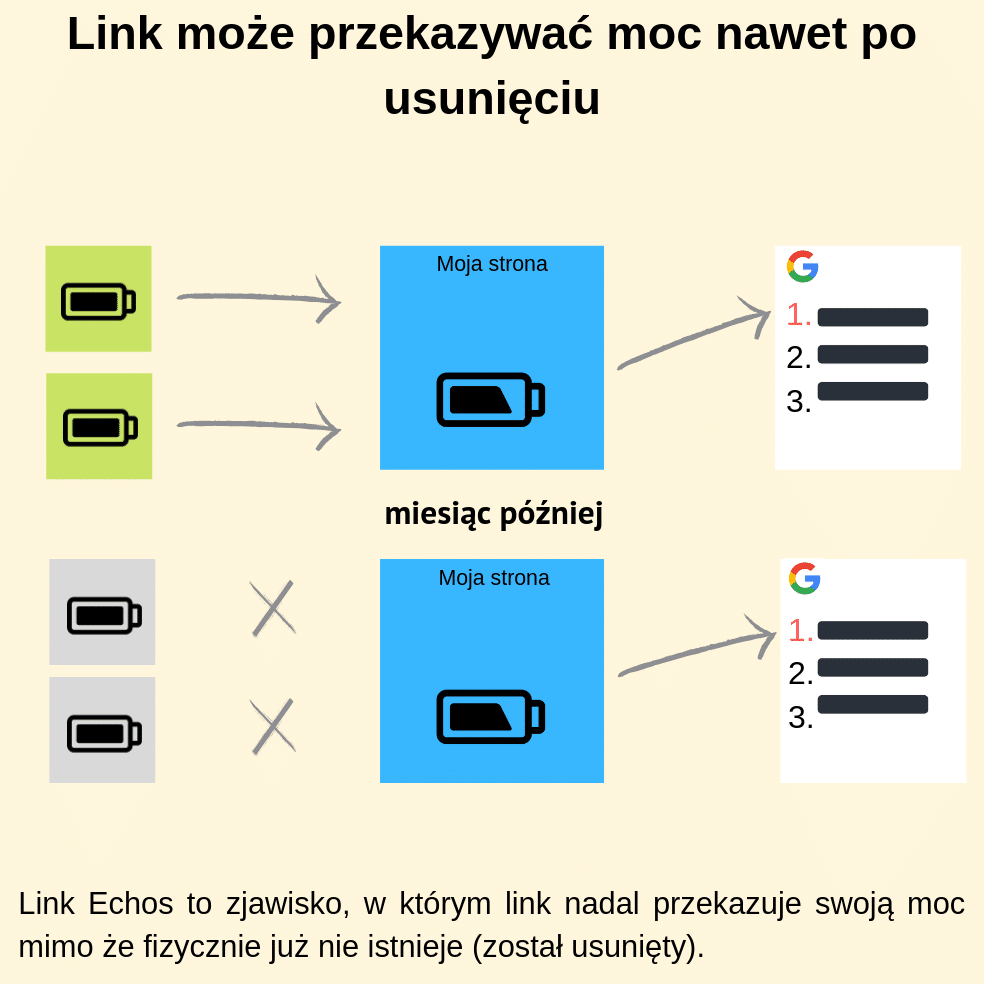

12. Link może przekazywać moc nawet po usunięciu

Link Echos (Link Ghosts) to zjawisko, w którym dany link, nawet po jego fizycznym usunięciu nadal jest zauważalny w profilu linkowym domeny i wpływa na jej ranking.

Wielokrotnie prowadzone przez SEO-wców na całym świecie testy dowiodły, że zjawisko to istnieje i jest trwałe – linki potrafią być widoczne i przekazywać moc nawet przez kilka miesięcy po ich usunięciu.

Należy jednak podkreślić, że nie zawsze tak jest – szczerze mówiąc nie jesteśmy w stanie przewidzieć, które linki Google “przetrzyma” w swojej pamięci po usunięciu, a które przestanie brać pod uwagę. W zależności od testu widoczność strony potrafiła jednak znacznie ucierpieć po usunięciu linków.

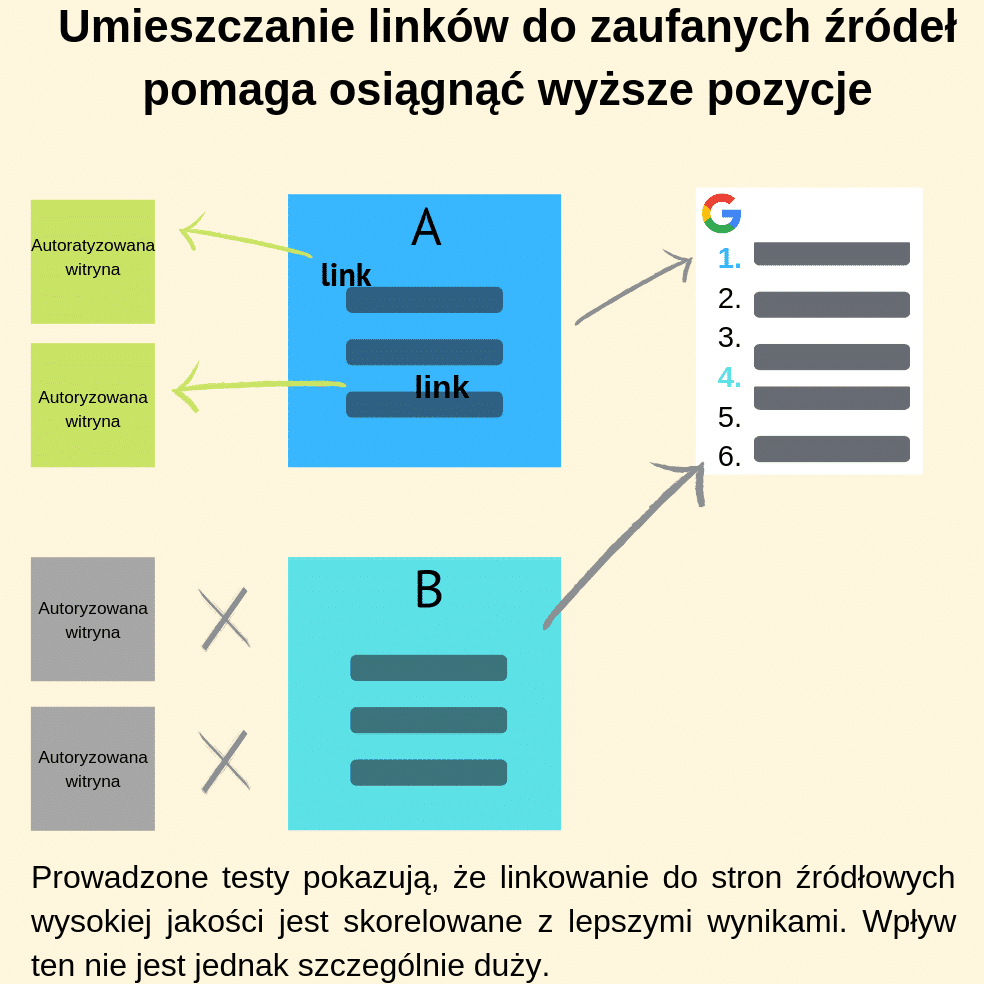

13. Umieszczanie linków do zaufanych źródeł pomaga osiągnąć wyższe pozycje

W przypadku tej tezy istnieją rozbieżne informacje ze strony specjalistów Google – z jednej strony twierdzą, że linkowanie do witryn autorytatywnych nie jest czynnikiem rankingowym, ale w przeszłości wspominali, że może to wpływać na wyniki. Napisał o tym Matt Cutts (były szef do walki ze spamem w Google).

“In the same way that Google trusts sites less when they link to spammy sites or bad neighborhoods, parts of our system encourage links to good sites.” Co w wolnym tłumaczeniu oznacza: “Google mniej ufa witrynom, które linkują do małowartościowych stron i zachęca do tego, aby w chociaż w części linkować do zaufanych witryn”.

Testy przeprowadzane na przestrzeni lat pokazują, że dodawanie linków do odpowiednich, autorytatywnych witryn może mieć pozytywny wpływ na ranking i widoczność strony

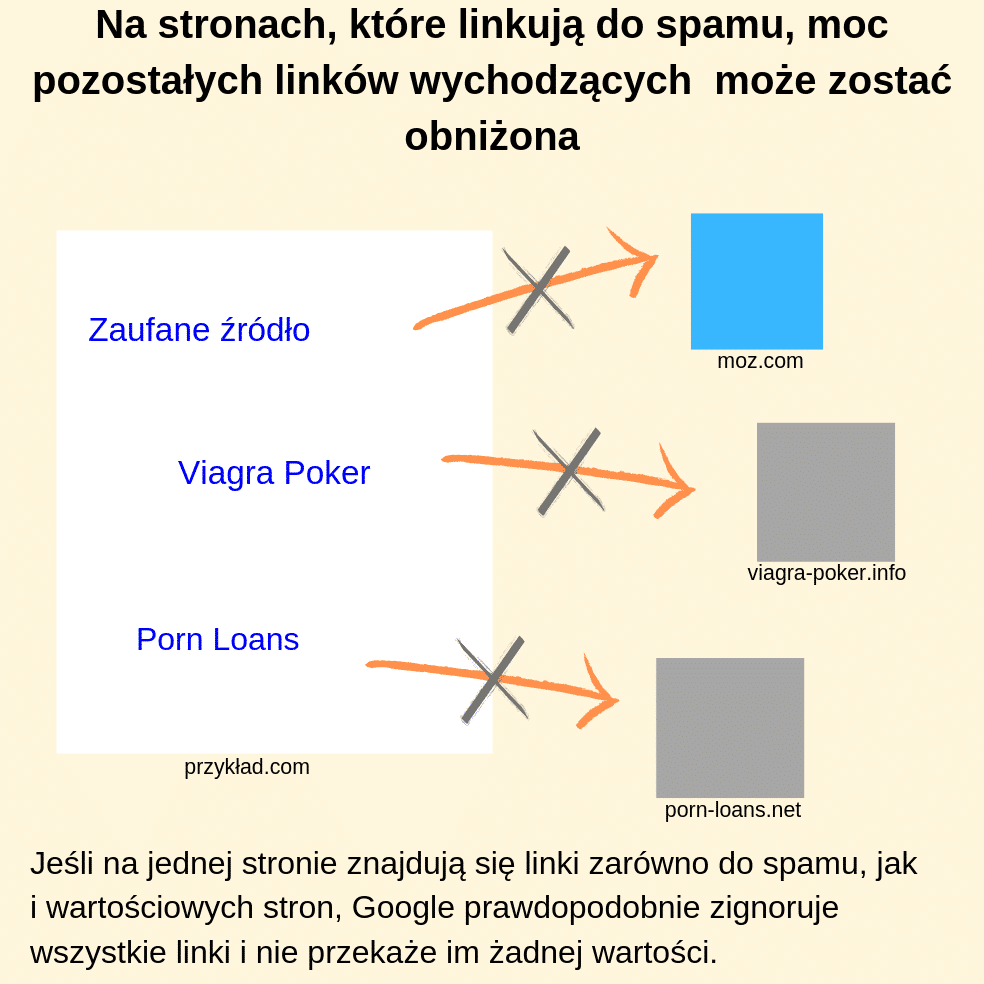

14. Na stronach, które linkują do spamu, moc pozostałych linków wychodzących może zostać obniżona

Wiemy, że Google nie lubi spamu i robi wszystko, aby udaremnić próby manipulowania wynikami wyszukiwania. Stąd w sytuacji, w której na jednej stronie znajdują się linki do spamu, czyli np. do stron o tematyce hazardowej czy pornograficznej i jednocześnie link do zaufanego źródła, np. strony rządowej, Google może sklasyfikować taką witrynę jako handlującą linkami i nie nada im żadnej mocy. Co więcej witryna taka może zostać uznana za spamerską, co uniemożliwi jej osiągnięcie wysokich pozycji w wynikach wyszukiwania.

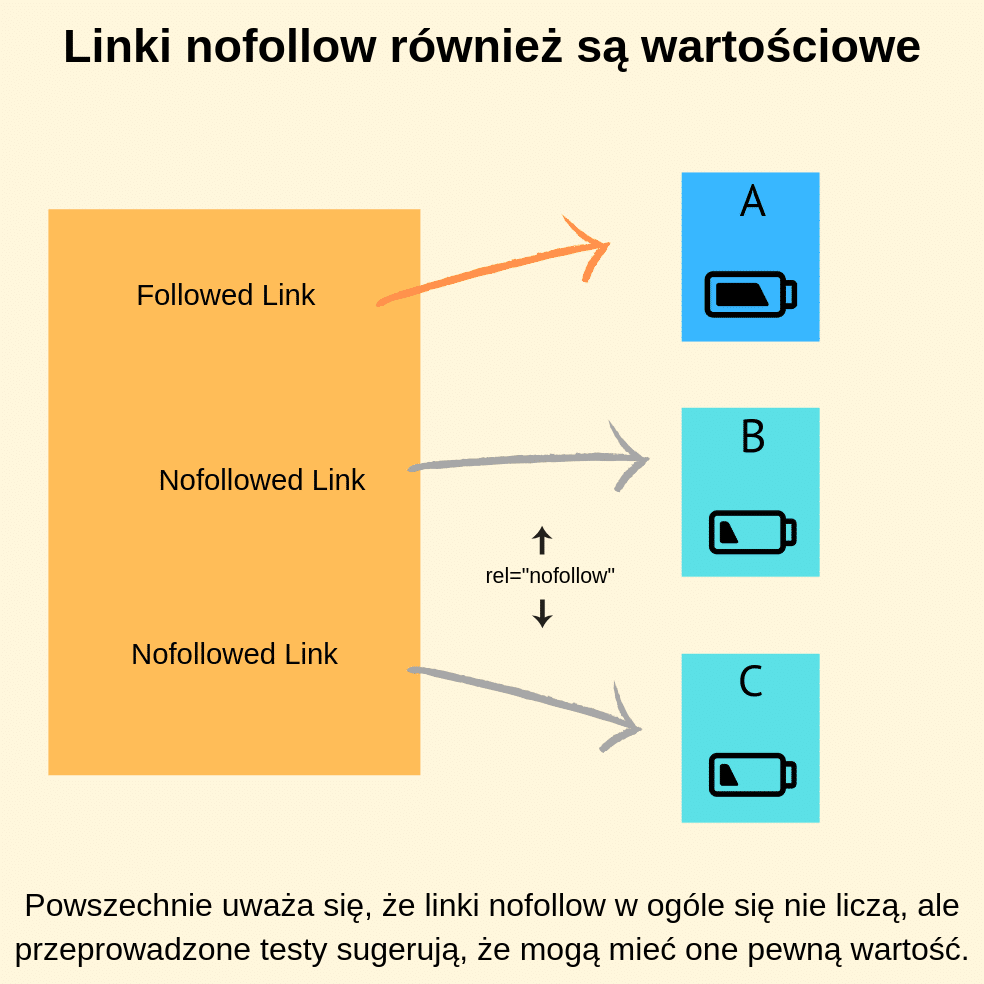

15. Linki nofollow również są wartościowe

Google wymyślił atrybut nofollow, aby ułatwić webmasterom walkę z niechcianymi linkami, publikowanymi na przykład przez użytkowników w komentarzach (aktualnie ma do tego służyć rel=”ugc”) czy oznaczania linków płatnych (tę rolę ma zaś przejąć rel=”sponsored”). Była to często spotykana praktyka, w celu nadania stronie jak największej wartości dzięki pozyskaniu dużej liczby prowadzącej do niej linków. I w takich właśnie sytuacjach zastosowanie rel=”nofollow” zabezpieczało webmasterów przed dzieleniem się link juicem swojej domeny z przypadkowymi stronami. Popularnym przekonaniem jest zatem, że linki oznaczone atrybutem nofollow są pomijane i nie dostają żadnej mocy.

W praktyce jednak liczne testy pokazują, że mogą mieć pewną wartość i warto je uwzględniać w profilu linkowym domeny. Nie wiadomo czy same linki dają jakąkolwiek wartość czy może chodzi o dywersyfikację i unaturalnienie profilu wszystkich linków kierujących do domeny. Jednak jednoznacznie widać, że tego typu linki w portfolio linków prowadzących do strony posiadać warto.

Wraz z ogłoszeniem przez Google komunikatu o wdrożeniu nowych atrybutów linków, tj. rel=”sponsored” oraz rel=”ugc” i informacją, że od teraz wszystkie linki typu „rel” mogą pelnić rolę wskazówek dla algorytmów oceniających linki, ten punkt artykułu z pewnością z czasem ulegnie rozszerzeniu lub zmianie. Póki co za szybko wyciągać jakiekolwiek wnioski, poza tym, że linki nofollow rzeczywiście mogą mieć jakiś wpływ na ranking.

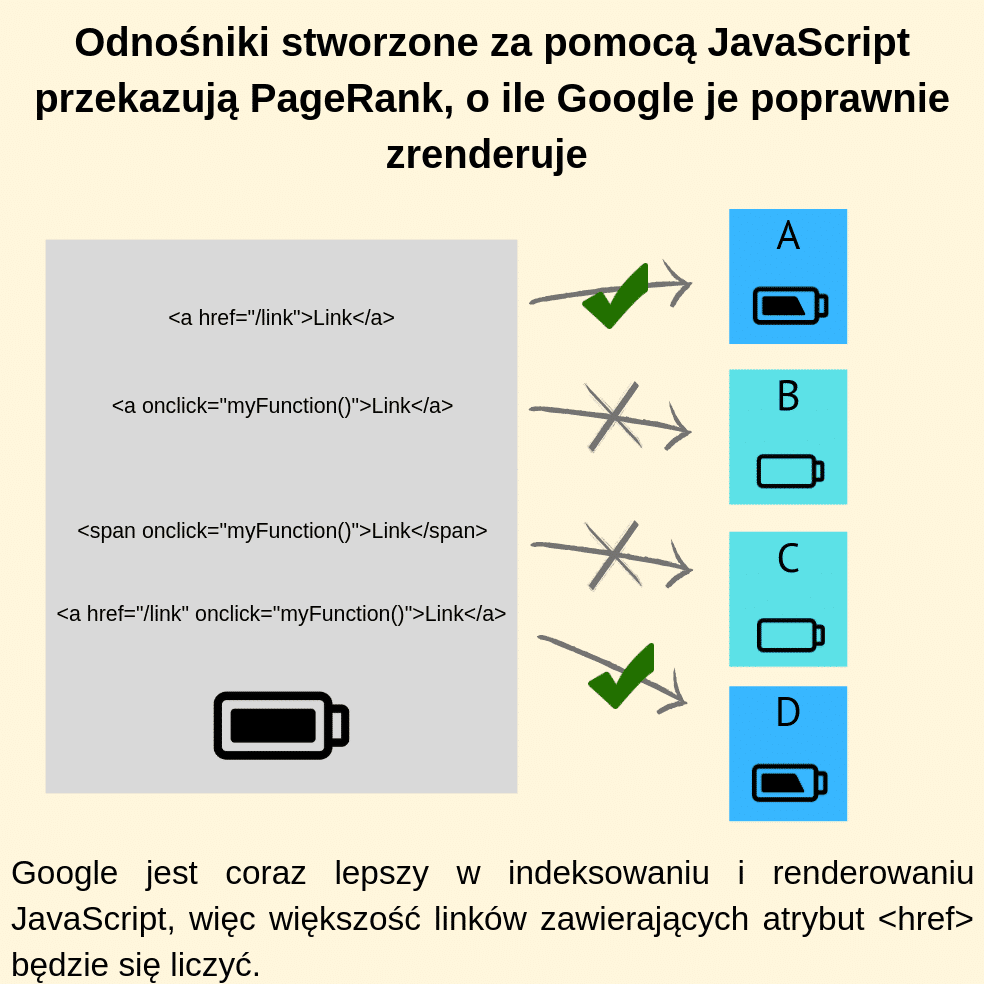

16. Odnośniki stworzone za pomocą JavaScript przekazują PageRank, o ile Google je poprawnie zrenderuje

Dawniej Google miało duże problemy z indeksacją stron wykonanych w technologii JavaScript, jednak obecnie radzi już sobie z tym zdecydowanie lepiej. Aktualnie Java Script zazwyczaj jest poprawnie renderowany, a linki indeksowane.

Należy jednak wiedzieć, że nadal istnieją formaty, których Google nie jest w stanie zaindeksować. Na ten moment indeksowane są tylko linki, które zawierają tag <href>. Mimo że Google radzi sobie z tym coraz lepiej, nadal trzeba być czujnym i dbać o właściwy kod, zgodny z wytycznymi Google.

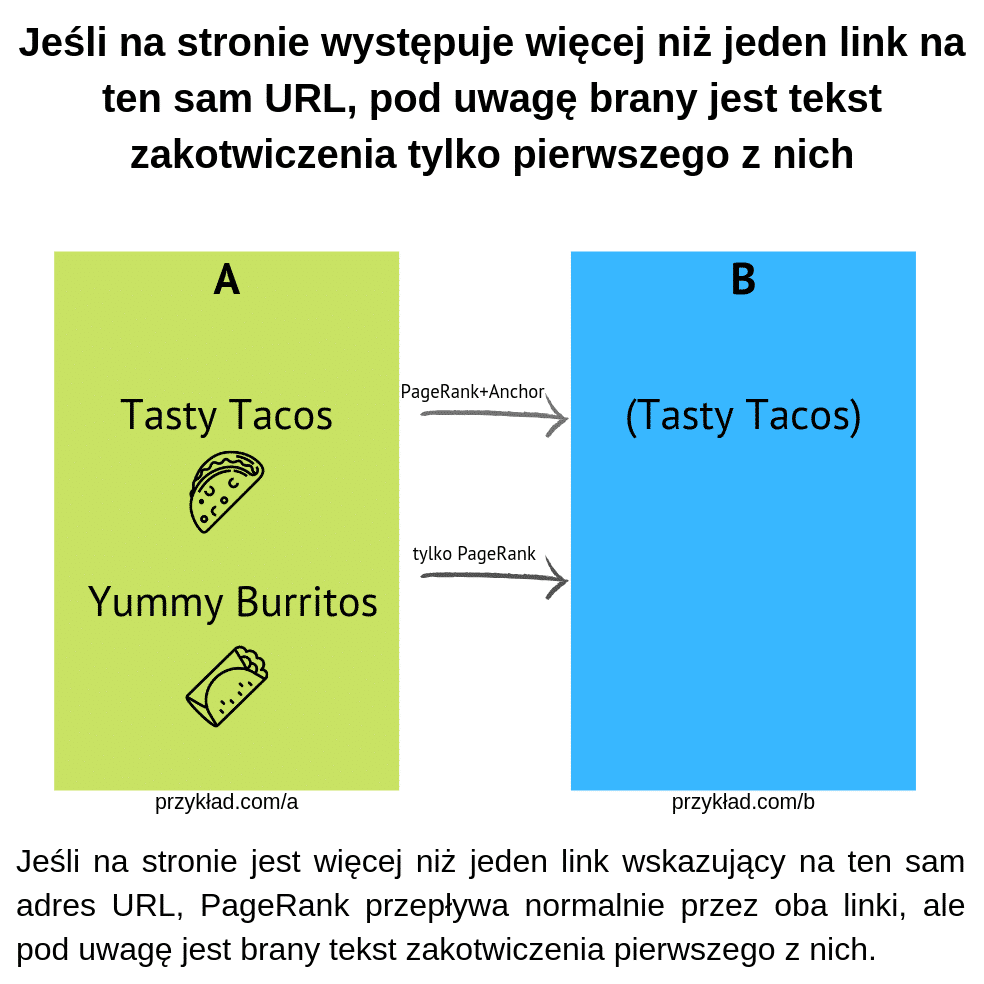

17. Jeśli na stronie występuje więcej niż jeden link na ten sam URL, pod uwagę brany jest tekst zakotwiczenia tylko pierwszego z nich

Jeśli na stronie umieścimy więcej niż jeden link do tego samego adresu URL, wtedy pod uwagę zostanie wzięty wyłącznie anchor pierwszego z nich. Łączy się to z zasadą First Link Count.

Wystąpienie więcej niż jednego linka do tego samego adresu URL zdarza się w sytuacji, gdy jeden z nich został umieszczony na stałe w nawigacji, a drugi dodaliśmy w treści danej podstrony. Warto pamiętać, że wtedy najprawdopodobniej zostanie wzięty pod uwagę tekst zakotwiczenia wyłącznie tego pierwszego odnośnika.

Istnieją sposoby na ominięcie tej zasady poprzez np. podlinkowanie adresu w wersji bez www (gdy domena skonfigurowana jest z uwzględnieniem www) lub poprzez linkowanie adresów, które są przekierowane. Przy czym nie zawsze to działa tak, jakbyśmy tego oczekiwali.

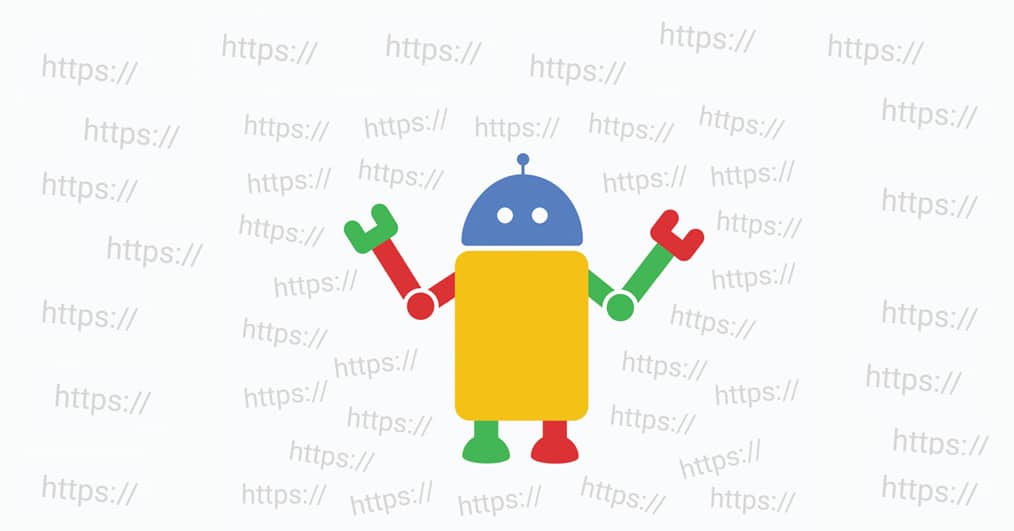

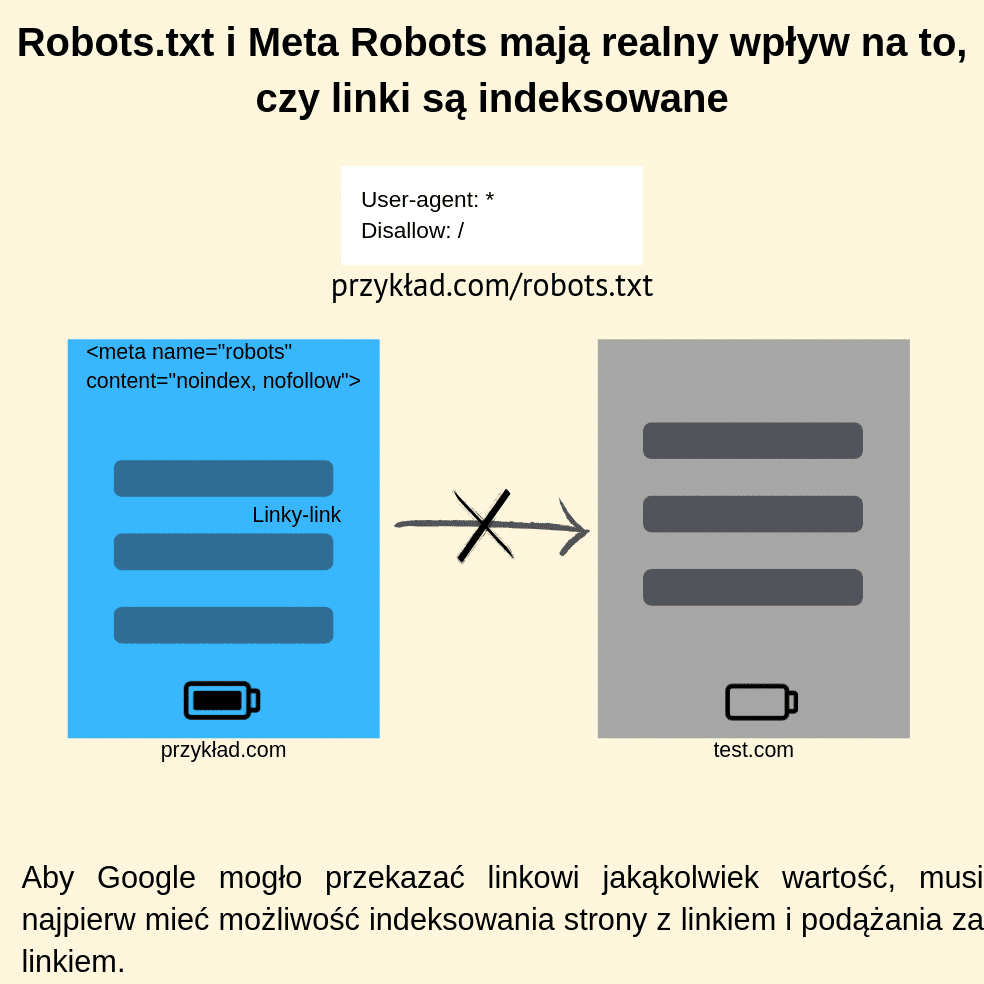

18. Robots.txt i Meta Robots mają realny wpływ na to, czy linki są indeksowane

Oczywistym jest, że aby Google mógł przekazywać moc linkom musi je indeksować i za nimi podążać. Należy więc pamiętać, że istnieją sytuacje, w których bot może nie mieć dostępu do danej podstrony, a w efekcie nie będzie przekazywał mocy linkom. Może tak się zdarzyć w sytuacji, gdy:

- adres URL, na którym umieszczony jest link został zablokowany w robots.txt przed crawlowaniem (dyrektywa disallow:),

- meta tag “robots” zawiera dyrektywę „nofollow”,

- meta tag “robots” zawiera dyrektywy „noindex, follow”, ale po dłuższym czasie Google zaprzestało ją crawlować.

Trzeba pamiętać, że jeśli zablokujemy możliwość crawlowania strony przez Google, to żadne linki na niej umieszczone nie będą brane pod uwagę.

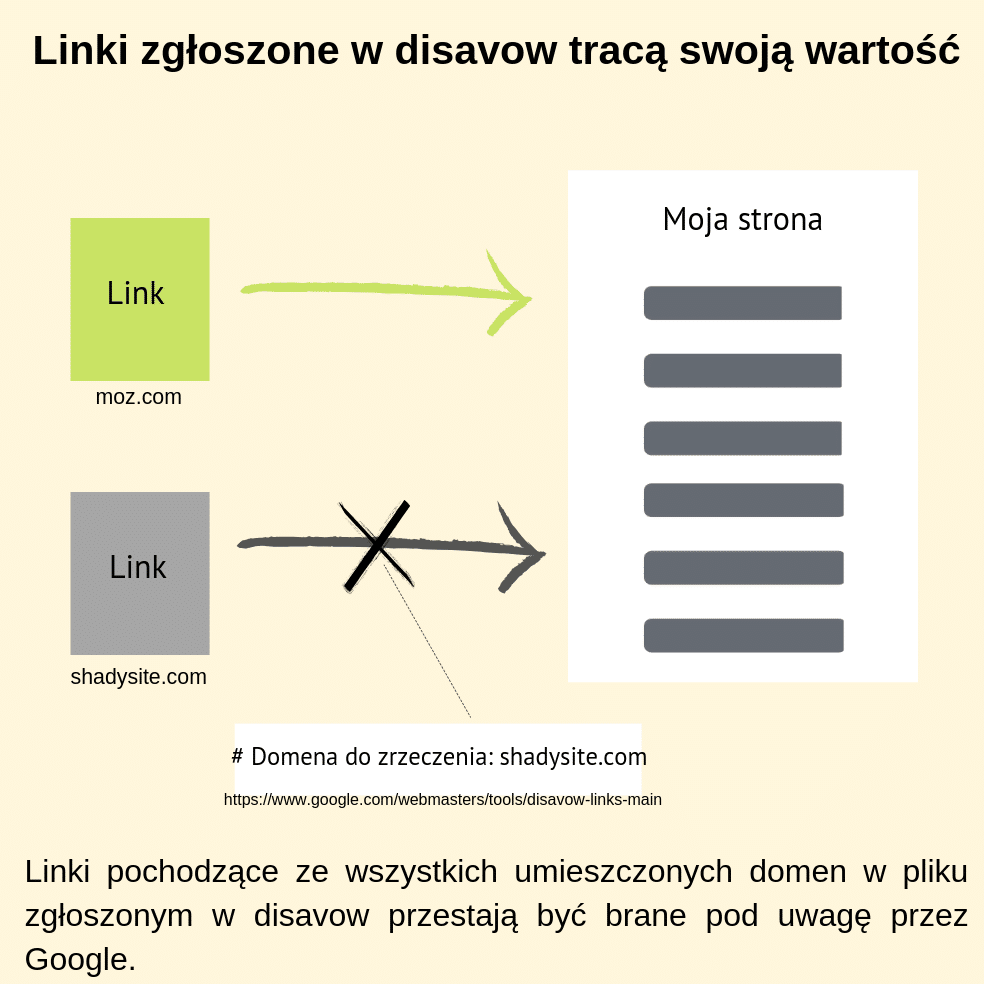

19. Linki zgłoszone w disavow tracą swoją wartość

Aby oczyścić profil linkowy domeny z małowartościowych lub spamerskich linków, Google zaleca skorzystanie z narzędzia do zrzekania się niechcianych linków, czyli Disavow Tool. Wszystkie niechciane linki umieszcza się w pliku, następnie przesyła do Google, by finalnie przestały być brane pod uwagę. Narzędzie przydaje się w przypadku chęci oczyszczenia profilu linków lub podczas podjęcia działań ratunkowych, gdy na domenę zostanie nałożona kara za nienaturalne linki.

Warto wiedzieć, że jeśli przez przypadek umieściliśmy na “czarnej liście” adres wartościowej domeny, Google może zidentyfikować to jako błąd i zignorować taką domenę. Mimo wszystko, podczas tworzenia listy do zgłoszenia w disavow należy być ostrożnym i dobrze przeanalizować domeny, których chcemy się zrzec. Trzeba uważać, żeby przypadkowo nie zrobić sobie samemu krzywdy.

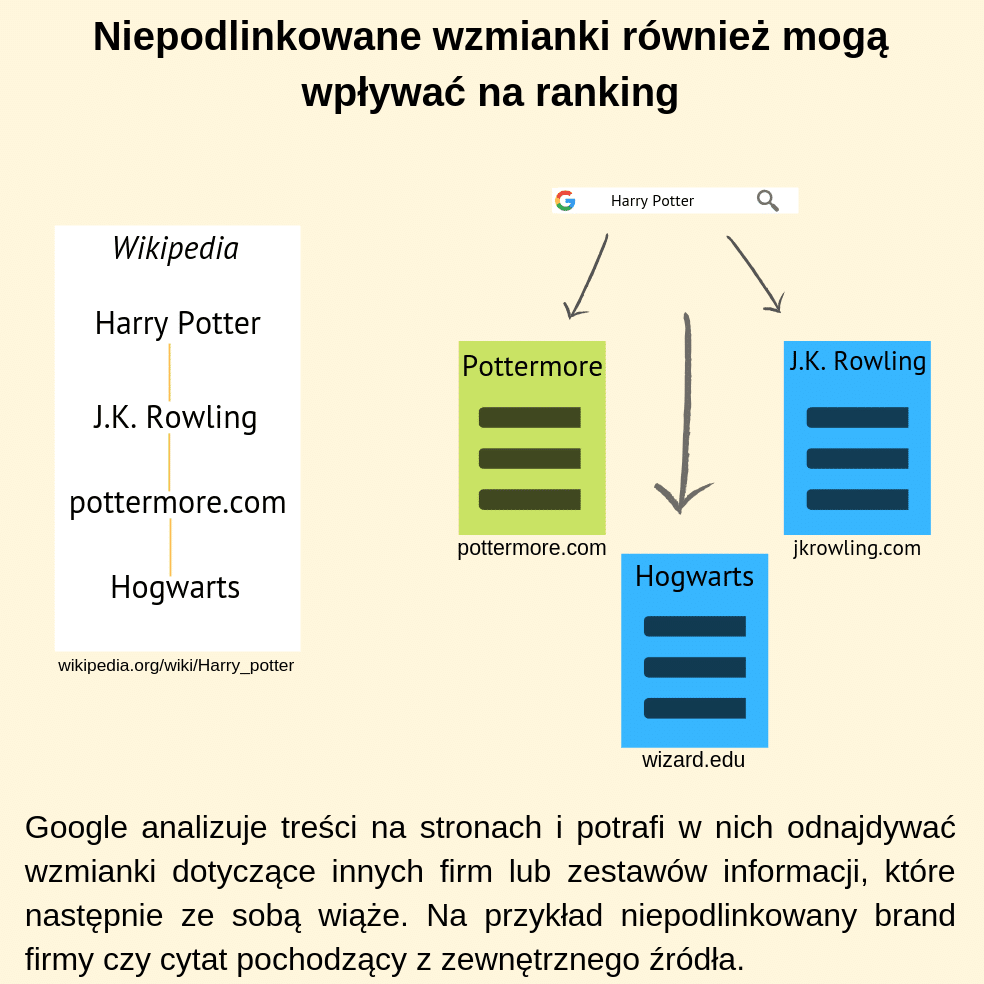

20. Niepodlinkowane wzmianki również mogą wpływać na ranking

Google potrafi łączyć ze sobą unikalne dane i wiązać je z daną witryną, zagadnieniem lub firmą bez obecności linków (na podstawie analizy treści). Jeśli więc na witrynie autorytatywnej nie posiadamy linka, ale wzmiankę o brandzie lub adresie URL, to również niesie za sobą wartość. Google potrafi wiązać adres URL z brandem, publikacje na lokalnych portalach z lokalizacją firmy czy aktora z filmami, w których odgrywał rolę. W ten sposób niektóre informacje potrafią łączyć się z daną stroną internetową lub tworzyć zestaw informacji nawet bez wiązania ich ze sobą odnośnikami.

Jak Google ocenia linki – podsumowanie

Na podstawie powyższego opracowania widać, że pozyskiwanie linków do witryny nie jest prostym zadaniem. A może inaczej, samo pozyskanie linka to jeszcze nie jest jakiś szczególny wyczyn, ale pozyskanie wartościowego odnośnika wymaga już specjalistycznej wiedzy i doświadczenia. Takie właśnie jest SEO – wymaga nieszablonowego podejścia, lat praktyki i setek testów. Praktycznie nie ma takiej rzeczy, która wygląda na prostą i rzeczywiście taką jest. No może poza optymalizacją title, ale z tym też warto mieć doświadczenie.

Wypełnij formularz

Przygotujemy dla Ciebie bezpłatną wycenę!

Dodatkowo otrzymasz bezpłatnie dostęp do kursów z marketingu internetowego.