Wyszukiwarka Google od początku swojego istnienia oparta jest o algorytmy, które obecnie spośród biliona zaindeksowanych stron internetowych potrafią wyświetlić konkretną odpowiedź na zadane przez użytkownika pytanie. Algorytmy Google (oraz innych wyszukiwarek) to inaczej programy komputerowe, które określają ranking strony na podstawie bardzo dużej liczby czynników.

Google nieustannie dąży do tego, aby jak najtrafniej wyświetlić użytkownikowi wyniki wyszukiwania. Oprócz tego chce osiągnąć jak najlepszą dywersyfikację wyników, aby tym samym zwiększyć szanse pojawienia się w TOP10 strony, która jak najlepiej odpowiada zapytaniu wpisanemu przez użytkownika. To, czy dana strona pojawi się wysoko w wynikach wyszukiwania, zależne jest od ponad 200 niepowtarzalnych wskaźników, z których każdy jest odpowiednio sprawdzany przez algorytmy. Każdorazowa zmiana jednego z tych elementów ma wpływ na konkretną pozycję witryny w wynikach wyszukiwania.

Firma Google została założona w 1998 roku przez Larry’ego Page’a i Siergieja Brina. Ich flagowy produkt, jakim niewątpliwie jest wyszukiwarka internetowa, powstał jako projekt studencki już w 1996 roku i pierwotnie nazwany był BackRub. Po założeniu spółki Google Inc. wyszukiwarka została uruchomiona pod nazwą „Google”, czyli niepoprawnie zapisanym słowem „googol”, które oznacza niewyobrażalnie wielką liczbę 10100 (w zapisie dziesiętnym jedynka i sto zer) – oraz wystartowała strona google.com.

PageRank

Pierwotnym algorytmem, na którym została oparta wyszukiwarka Google, jest opatentowany przez założycieli firmy Google system PageRank. Wbrew pozorom nazwa tego algorytmu nie pochodzi od angielskiego słowa „page” określającego stronę, lecz od nazwiska jednego z twórców firmy, czyli Larry’ego Page’a.

Algorytm PageRank opierał swoje działanie na obliczaniu wartości strony (również określanej jako PageRank) w skali od 0 do 10 na podstawie ilości witryn, które się na nią powoływały oraz samych ich wartości. Szczegóły obliczania nie zostały jednak nigdy upublicznione i są do dnia dzisiejszego jedną z tajemnic firmy.

Wartość PageRank danej strony można było sprawdzić za pomocą wielu niezależnych serwisów lub też specjalnego rozszerzenia do przeglądarek. PageRank zaczął jednak być stopniowo wycofywany jako wskaźnik wartości stron internetowych. Najpierw w 2009 roku Barry Schwartz na swoim blogu opublikował informację, że PageRank został usunięty z usługi Google Webmaster Tools (obecnie Google Search Console). Samą wartość PageRank Google przestało aktualizować już w 2014 roku (ostatnia aktualizacja miała miejsce w 2013), a ostatecznie firma całkowicie usunęła narzędzie Google PageRank ze swojej wyszukiwarki w 2016 roku. Warto jednak dodać, że Google od wielu lat powtarzało, że współczynnik PageRank nie jest głównym czynnikiem określającym wartość danego serwisu.

Obecnie można śmiało stwierdzić, że współczynnik PageRank całkowicie umarł i aż dziwne jest, że tak wiele osób oferujących umieszczenie wpisu czy odnośnika na swojej stronie powołuje się jeszcze na jego PageRank.

Od czasu, gdy wyszukiwarka Google zyskała na popularności użytkowników wyszukujących w niej informacje, zwiększała się też ilość osób, które chciały się w niej promować. W ten sposób nie zabrakło „pozycjonerów”, którzy znaleźli wiele sposobów, aby sztucznie zwiększać wartość PageRank i tym samym wyprzedzać strony konkurencji w wynikach wyszukiwania.

Dodatkowym elementem, który wpływał na korelację serwisu z daną frazą kluczową, było meta tag „keywords”:

<meta name="keywords" content="słowo kluczowe 1, fraza 2, wyrażenie 3">

Meta tag szybko jednak przestał być brany pod uwagę, ponieważ Google stwierdziło, że jest to zbyt prosty sposób na określanie tematyki witryny, a użytkownicy nadmiernie umieszczali w nim dużą ilość fraz i tym samym nadużywali jego pierwotne zastosowanie.

Google od tego czasu wprowadziło wiele dodatkowych algorytmów, które z czasem zmniejszały wartość współczynnika PageRank do zera i do tej pory wprowadzane są zmiany w nieustannie trwającej walce z „pozycjonowaniem” niezgodnym z wytycznymi Google.

Skąd w ogóle potrzeba tych zmian?

W 2015 roku na jednej z wideokonferencji John Mueller zakomunikował, że firma Google każdego roku wprowadza tysiące zmian w swoich algorytmach, które poprzedzone są dziesiątkami tysięcy wykonanych testów. Można tylko podejrzewać, iż Google z roku na rok wprowadza coraz więcej ulepszeń algorytmów o coraz większym znaczeniu.

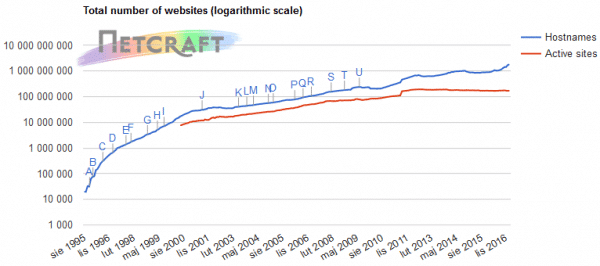

Źródło: Netcraft.com

Według statystyk firmy Netcraft, która od wielu lat monitoruje ilość stron internetowych wynika, iż w styczniu 2010 roku aktywnych było ponad 200 milionów stron internetowych (obecnie jest ich 1,8 miliarda). Tak duża ilość serwisów – pomimo obecnego zaawansowania algorytmów wyszukiwarki Google – wymaga nieustającej walki ze spamem oraz nowymi, niezgodnymi z wytycznymi Google technikami, jakie są używane do zwiększania pozycji w wyszukiwarce. Firma w walce z tego typu praktykami w swoich zmianach postawiła przede wszystkim na ocenę jakości strony internetowej. W tym celu powstał pierwszy „zwierzak” Google – Panda.

Aktualizacja algorytmu Panda

Pierwsze oznaki zdecydowanych zmian w algorytmach można było zauważyć już w maju 2010 podczas aktualizacji May Day, którą Matt Cutts potwierdził jako zmianę wpływającą na wyniki długiego ogona (ang. long tail), sugerując tym samym nadejście Pandy.

Kolejną zapowiedzią nowego algorytmu było nałożenie kary dla dużych serwisów JCPenney oraz Overstock.com za wykorzystywanie niezgodnych z wytycznymi Google praktyk pozyskiwania linków. Nałożenie kary na tak duże serwisy przedstawiło zmianę podejścia Google do stosowania niedozwolonych z ich polityką działań.

Oficjalnie 23 lutego 2011 roku miała miejsce jedna z największych zmian w algorytmach Google – Panda. Nowy algorytm, którego nazwa pochodzi od jego twórcy, inżyniera Google Navneeta Pandy, wzbudził wiele kontrowersyjnych emocji wśród użytkowników i stał się nowym standardem w ocenie stron internetowych.

Głównym założeniem nowego algorytmu było podniesienie rankingu stronom, które wyróżniały się wysoką jakością, oraz obniżać lub też karać witryny, których informacje wzbudzały wątpliwości lub też naruszały wytyczne Google. Jak się okazało, nowy algorytm był bardzo restrykcyjny w ocenie serwisów, co skutkowało nakładaniem kar na np. tzw. farmy treści (ang. content farm) – czyli strony, które prezentowały bardzo dużą ilość informacji skopiowanych z innych serwisów, tworząc tym samym wiele podstron. Nałożenie kary przez nowy algorytm było bardzo odczuwalne, ponieważ najczęściej karana była cała witryna, a nie poszczególne podstrony, które de facto zawiniły.

Algorytm obniżył wartość stronom, które przede wszystkim:

- powielały treści i informacje zawarte w innych serwisach internetowych,

- posiadały znikomą ilość informacji lub ich treści zawierały błędne i stare informacje, błędy gramatyczne i składniowe,

- obejmowały zbyt duże nasycenie wyrażeniami kluczowymi, które było odbierane jako próba sztucznego nasycenia frazami,

- automatycznie generowały duże ilości małowartościowego contentu,

- prezentowały dużą ilość banerów, reklam, a tematyczna treść była trudno dostępna,

- powielały serwisy tworząc tzw. „serwisy bliźniacze” lub tworzyły nowe podstrony przejściowe.

Z drugiej strony na algorytmie zyskały oraz wciąż zyskują strony, które nieustannie dbają o jakość swojego contentu pod kątem unikalnych i użytecznych informacji, dążąc do bycia autorytetem w branży oraz stając się źródłem przydatnej wiedzy. Serwisy, które podniosły swoje pozycje po wejściu w życie nowego algorytmu, cechują się przede wszystkim:

- unikalnymi, obszernymi oraz w pełni wyczerpującymi dany temat treściami,

- bardzo dobrze opisaną ofertą na stronie,

- stronami wpływającymi na zaufanie firmy, takimi jak: O firmie, FAQ, Regulamin,

- stronami przedstawiającymi daną firmę jako eksperta w branży, zawierającymi np. certyfikaty, opinie, referencje,

- wartością dodaną w postaci poradników, bloga, aktualności, nowości, porównań produktów,

rozbudowanymi elementami kontaktu, np. formularzem kontaktowym, wskazówkami dojazdu i pełnymi danymi teleadresowymi.

Warto zwrócić uwagę na fakt, iż algorytm ten nieustanie jest aktualizowany i udoskonalany przez Google, więc jeżeli strona już znajduje się na wysokiej pozycji, nie jest powiedziane, że bez ciągłego dbania o jej jakość ta pozycja się utrzyma. Poniżej tabela ze zmianami w algorytmie na przestrzeni ostatnich lat:

Panda 1.0

Wejście w życie pierwszej wersji algorytmu oraz ukaranie stron z bardzo dużą ilością niskiej jakości podstron.

24.02.2011

Panda 2.0

Google rozwinęło swój algorytm dla wszystkich wersji języka angielskiego (nie tylko dla krajów anglojęzycznych).

11.04.2011

Panda 2.1

Początkowo nazwany Panda 3.0. Pierwsze niewielkie zmiany w algorytmie. Google nie ujawniło szczegółów.

9.05.2011

Panda 2.2

Pierwsze duże zmiany w algorytmie, obejmujące walkę z automatycznie generowanym, nieunikalnym contentem.

21.06.2011

Panda 2.3

Google wprowadziło kolejne nowe czynniki do walki z niskiej jakości contentem.

23.07.2011

Panda 2.4

Rozwinięcie algorytmu dla zapytań anglojęzycznych na całym świecie oraz nieanglojęzycznych za wyjątkiem chińskiego, japońskiego i koreańskiego.

12.08.2011

Panda 2.5

Po ponad miesiącu Google wprowadza kolejne kryteria do oceny jakości contentu na stronie.

28.09.2011

Panda 3.1

Po wersji 2.5 Google wprowadziło zapowiadany już 5.10.2011 przez Matta Cuttsa okres częstych aktualizacji. Pomimo braku wersji 3.0 niektórzy analitycy nazwali aktualizację 3.1.

18.11.2011

Panda 3.2

Firma Google poinformowała o aktualizacji algorytmu Panda, chociaż sugerowała, że sposób działania algorytmu się nie zmienił.

18.01.2012

Panda 3.3

Google odświeżyło temat częstych aktualizacji Pandy kilka dni po rocznicy algorytmu i poinformowało o zmianach, dzięki którym strony będą precyzyjniej oceniane przez algorytm.

27.02.2012

Panda 3.4

Google opublikowało na Twitterze informację, że kolejna aktualizacja dot. oceny stron o niskiej jakości wpłynęła na ok. 1,6% wyników wyszukiwania.

23.03.2012

Panda 3.5

Kolejne zaostrzenie się algorytmu pod kątem oceny jakości – nowa mieszanka zmian nie miała wielkiego wpływu na wyniki wyszukiwania.

19.04.2012

Panda 3.6

Tydzień po wersji 3.5 Google wprowadziło nową aktualizację, jednak nie są znane szczegóły zastosowanych zmian. Wpływ na wyniki nie był bardzo odczuwalny.

27.04.2012

Panda 3.7

Aktualizacja algorytmu, która ponoć miała dotknąć mniej niż 1% wyników, jednak wpływ był znacznie wyższy niż przy wersjach 3.5 i 3.6.

8.06.2012

Panda 3.8

Google ogłosiło aktualizację danych – bez zmian w algorytmie. Wpływ wdrożenia zmian był mniejszy niż przy poprzedniej aktualizacji.

25.06.2012

Panda 3.9

Aktualizacja algorytmu Google, która spowodowała spore fluktuacje wyników przez prawie tydzień, chociaż w żadnym dniu zmiany nie były aż tak zauważalne. Zmiany według Google dotyczyły ok. 1% zapytań.

24.07.2012

Panda 3.9.1

Aktualizacja zmian w algorytmie z niewielkim wpływem na wyniki. Ze względu na drobne zmiany dodano wersję 3.9.1.

20.08.2012

Panda 3.9.2

Kolejne małe odświeżenie Pandy, które miało umiarkowany wpływ na wyniki wyszukiwania.

18.09.2012

Panda Refresh

Oficjalnie nazwana zmiana algorytmu Refresh – wpływ na ok. 1,3% zapytań w języku angielskim.

21.12.2012

Panda #24

Pierwsza oficjalna aktualizacja Pandy w 2013 roku, która była 24. z kolei aktualizacją tego algorytmu, dotyczyła ok. 1,2% zapytań.

22.01.2013

Panda #25

25. aktualizacja algorytmu, którą wstępnie ogłosił Matt Cutts. Dodał również, że będzie to ostatnia aktualizacja algorytmu ingerująca w silnik algorytmu. Dokładne dane zmiany nie zostały potwierdzone.

14.03.2013

Panda Dance

Matt Cutts potwierdził, że algorytm Panda jest co miesiąc aktualizowany, ale aktualizacje są wdrażane powoli, co powoduje zmienność wyników wyszukiwania, tzw. Google Dance.

11.06.2013

Panda Recovery

Google potwierdziło kolejną zmianę, jednak nie było do końca wiadomo, czy to coś nowego, czy długofalowy proces wdrożenia poprzednich zmian. Wpływ aktualizacji miał zmniejszyć wcześniej nałożone przez Pandę kary.

18.07.2013

Panda 4.0

Google potwierdziło dużą zmianę w algorytmie Panda – zarówno danych, jak i samego algorytmu. W zależności od języka zmiana dotyczyła wyników wyszukiwania w różnym stopniu. Dla języka angielskiego są to zmiany 7.5% zapytań, które dostrzeże przeciętny użytkownik.

19.05.2014

Panda 4.1

Wpływ zmian nowego algorytmu na ok. 3-5% zapytań. Celem zmian było zwiększenie wartości małych i średnich stron, które wyróżniały się wysoką jakością. Dało to szansę przebić się w wynikach przez znane i duże marki, których treści nie były dostatecznie wartościowe.

23.09.2014

Panda 4.2

Według Google zmiana nowego algorytmu będzie odczuwalna przez kilka kolejnych miesięcy i odczuwalna w ok. 2-3% zapytań anglojęzycznych.

17.07.2015

Wskazówka:

Jeżeli strona ma być liderem w wynikach wyszukiwania, powinna zasłużyć na to miano bogactwem unikalnych, wartościowych i użytecznych informacji. Zadbajmy więc o to, aby nasza strona wyróżniała się na tle konkurencji dużą ilością fachowych informacji, działem poradników oraz podstronami, które przedstawią firmę jako lidera i autorytet w branży.

Jeżeli, przeglądając strony konkurencji, widzimy strony podobne do naszej, to znak, że powinniśmy zainwestować w poprawienie swojej strony. Google doceni nasze starania, a strona zyska na jakości.

Aktualizacja algorytmu Pingwin (ang. Penguin)

Kolejnym zwierzem z algorytmicznej zagrody Google i drugim wzbudzającym kontrowersje oraz najbardziej znanym algorytmem, jest Pingwin (ang. Penguin). Nowy algorytm pojawił się 24 kwietnia 2012 roku, a jego głównym zadaniem było zmniejszenie wartości serwisów, do których prowadzą linki z niskiej jakości stron lub też charakter tych linków jest podejrzany.

Każdy link do pozycjonowanej strony internetowej wpływa na jej docelową wartość. Pozyskując odnośnik z popularnego i wartościowego serwisu, który w oczach Google ma wysoką wartość, zwiększamy tym samym wartość naszej strony. Jeżeli linków z mniej wartościowych serwisów będzie więcej, mogą one przynieść podobny efekt jak pojedyncze linki z wartościowych stron. Z tego faktu przed kilkoma laty zaczęto dywersyfikować profil linkowy serwisów, dodając linki z różnych typów stron, jak np. katalogów, forów, komentarzy czy blogów.

Pingwin podobnie do Pandy potrafi karać zarówno pojedyncze podstrony, jak i całe witryny. Podobnie jak w innych algorytmach, Google nie ujawniło dokładnych reguł działania algorytmu, jednak na podstawie sporej ilości przypadków i analiz można z dość dużym prawdopodobieństwem oszacować, co sprawia, że strona ma większą wartość, a jaki sposób zdobywania linków naraża stronę na utratę pozycji.

Algorytm ma za zadanie ocenę profilu linkowego serwisu (czyli wszystkich linków kierujących do domeny) i określenie ewentualnego wzorca, który może świadczyć o próbie automatycznego i sztucznego pozyskiwania linków. Ocenia się wówczas:

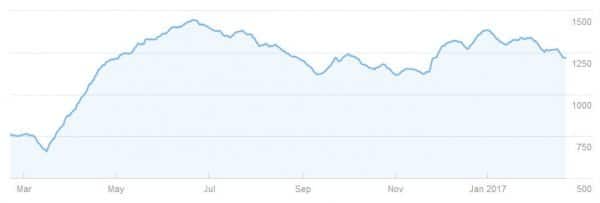

– przyrost linków w czasie

Przed wejściem algorytmu w życie, narzędzia, które pozwalały w jednym dniu automatycznie dodać stronę do setek katalogów, umożliwiały również wypracowanie wysokich pozycji. Google mocno wzięło pod uwagę daty pojawiających się linków, dzięki czemu potrafi określać, czy przyrost linków do strony jest naturalny, czy może on oznaczać sztuczne ich nabywanie.

Jeżeli linki, które kierują do naszej strony, były publikowane w różnych odstępach czasowych w naturalnym tempie (tak jak możliwa jest publikacja odnośnika przez człowieka), wówczas taki profil linkowy można uznać za naturalny.

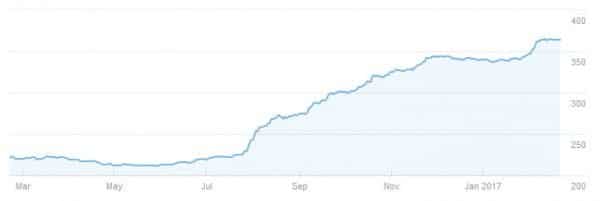

Prawidłowy przyrost linków w czasie.

Jeżeli zaś do naszej strony w krótkim odstępie czasu zostanie opublikowana duża ilość linków, wówczas algorytm zauważy nienaturalny przyrost linków i zwiększy się ryzyko obniżenia wartości strony czy też nawet nałożenia na stronę kary.

Nieprawidłowy przyrost linków w czasie.

– jakość odnośników

Oprócz oceny ilości danych odnośników, bardzo ważna jest również ich jakość – a przede wszystkim jakość serwisów, na których taki odnośnik jest umieszczany. Ze względu na to, iż nie jesteśmy w stanie kontrolować tego, kto i gdzie publikuje link do naszej strony, uznajmy, że dobrze ocenianym profilem linkowym jest ten, który zdecydowaną większość backlinków (linków zwrotnych) posiada z wartościowych i zaufanych serwisów, a jedynie mały ułamek to strony o niskiej jakości. W sytuacji, gdy do strony prowadzi zdecydowana większość linków, które:

- pochodzą z niskiej jakości katalogów lub innych serwisów,

- są otoczone spamerskimi i automatycznie wygenerowanymi treściami,

- obejmują powielone w różnych miejscach treści,

- są kierowane głównie na skorelowane ze sobą frazy kluczowe,

wówczas algorytm może przyjąć, iż profil ten jest próbą manipulacji rankingiem i obniży wartość stronie.

– dywersyfikacji linków

Bardzo ważną kwestią jest ilość typów stron linkujących. Jeżeli posiadamy linki z popularnych i wartościowych katalogów, które zdobyliśmy ręcznie, dodając stronę w różnych odstępach czasowych, ale wszystkie opublikowane do naszej strony linki są jednak z katalogów opartych o ten sam skrypt, wówczas możemy nie uzyskać oczekiwanego efektu w postaci zwiększenia wartości strony. Prawidłowo zróżnicowany profil linkowy to taki, który cechuje się odnośnikami pochodzącymi z różnych źródeł, np. katalogów, forów, blogów, stopek innych serwisów, stron o innej i tej samej tematyce, ogłoszeń oraz serwisów społecznościowych.

Pingwin po wykryciu naruszenia jednej z powyższych kwestii obniża pozycje strony na część wyrażeń kluczowych lub na wszystkie. W zależności od charakteru naruszenia wytycznych możemy spotkać się z filtrami częściowymi, które nakładane są na: pojedyncze frazy kluczowe (pojawiające się najczęściej jako fraza linkowana), pojedyncze podstrony (najczęściej wskazywane linkami) oraz całe serwisy.

Po nałożeniu na stronę kary algorytmicznej od Pingwina odzyskanie wysokich pozycji jest bardzo trudne, a przede wszystkim czasochłonne. Należy wówczas usunąć wszystkie potencjalnie szkodliwe odnośniki, które kierują do naszej strony, i czekać na efekt. Warto również spróbować zgłosić te linki w specjalnym narzędziu do zrzekania się odnośników Disavow Tool. Z doświadczenia jednak wiadomo, iż usunięcie nawet wszystkich linków niskiej jakości oraz zrzeknięcie się ich przez długi czas może utrzymywać naszą stronę na niskich pozycjach. Taki „ślad”, który zostawiają po sobie nienaturalne linki, jest jednym z powodów, dla których warto być uważnym przy budowie profilu linkowego.

Chcesz być widoczny dla klientów w swojej okolicy? Wypróbuj nasze usługi pozycjonowania lokalnego! Zapytaj o szczegóły naszych planów już teraz.

Wskazówka:

Nie warto kupować linków na znanych portalach aukcyjnych czy też korzystać z masowej ilości publicznych katalogów opartych o stare skrypty SEO. Zdecydowanie lepiej budowę profilu linkowego rozpocząć od pozyskania jak najbardziej wartościowych linków ze znanych źródeł, takich jak:

- katalogi biznesowe typu Yellow Pages,

- linki z portali społecznościowych,

- wpisy w katalogach popularnych portali informacyjnych,

- linki na serwisach lokalnych partnerów.

Warto pamiętać, że nawet pojedyncze linki potencjalnie mogą szkodzić i wpływać na obniżenie wartości całego serwisu, a co za tym idzie – znacznie utrudnić uzyskanie wysokich pozycji. Dodatkowo dobrze upewnić się, czy publikując gdziekolwiek odnośnik do swojej strony, mamy nad nim kontrolę, aby w razie takiej potrzeby móc go zmodyfikować czy też usunąć.

Algorytm Pingwin, podobnie jak Panda, od swojej pierwszej wersji doczekał się wielu udoskonaleń, aby jak najtrafniej móc oceniać jakość profilu linkowego. Wśród zmian od pierwszej wersji algorytmu możemy wymienić aktualizacje przedstawione w poniższej osi.

Pingwin 1.0

Oficjalne wejście w życie nowego algorytmu Pingwin.

24.04.2012

Pingwin 1.1

Wdrożona poprawka algorytmu, mająca na celu wyeliminowanie z wyników wyszukiwania tzw. stron przejściowych (ang. doorway pages). Zmiany nie dotyczyły Polski.

25.05.2012

Pingwin #3

Podobnie jak w przypadku Pandy wydana została aktualizacja bez oznaczania kolejnym numerem. Mała aktualizacja miała nieznaczny wpływ na ok. 0,3% zapytań i zbiegła się z kolejną zmianą w algorytmie Panda, stąd dodatkowo trudno było zauważyć jej wpływ.

5.10.2012

Pingwin 2.0

Zmiana w algorytmie wbrew temu, co zapowiadano, miała niewielki wpływ na pozycje. Algorytm miał jeszcze bardziej szczegółowo i konkretniej oceniać profile linkowe, wnikając w strukturę serwisu. Zaczęto oceniać indywidualnie każdą podstronę.

22.05.2013

Pingwin 2.1

Według Google jest to niewielka zmiana, która miała wpływać na ok. 1% zapytań, jednak jak się okazało – dotkniętych zostało zdecydowanie więcej.

4.10.2013

Pingwin 3.0

Po ponad roku wdrożona została nowa wersja Pingwina. Według informacji, jaką przekazał wówczas Gary Illyes, aktualizacja to nie zmiana obecnego algorytmu, tylko ponowne przepisanie całego kodu od nowa.

17.10.2014

Pingwin 3.1

Nie do końca potwierdzona aktualizacja algorytmu, która miała być wypuszczona w tzw. „black Friday”.

27.11.2014

Pingwin 3.2

Mała zmiana algorytmu, która nie została potwierdzona przez Google i miała niewielki wpływ na pozycje.

2.12.2014

Pingwin 3.3

Niepotwierdzona mała zmiana, która była odczuwalna w wynikach wyszukiwania.

5.12.2014

Pingwin 3.4

Dziesiąta zmiana w algorytmie Pingwin (niepotwierdzona przez Google).

6.12.2016

Pingwin 4.0 & real-time

Po prawie dwóch latach Google w końcu ogłosiło aktualizację Pingwina. Nowy algorytm działa obecnie w czasie rzeczywistym (real-time) oraz został włączony do głównego algorytmu, dlatego aby odczuć efekt jego oceny, nie będzie trzeba czekać na osobne odświeżenie. Dodatkowo nowa wersja Pingwina ma być bardziej szczegółowa i tym samym ostatnia. Kolejne poprawki algorytmu mają być wdrażane na bieżąco.

23.09.2016

Aktualizacja algorytmu Koliber (ang. Hummingbird)

Kolejnym ptakiem w algorytmach Google jest Koliber (ang. Hummingbird), który charakteryzuje się szybkością i precyzją. Data uruchomienia nowego algorytmu Google nie jest do końca znana. 20 sierpnia 2013 roku ujawniono fakt, iż algorytm ten został wdrożony już miesiąc wcześniej.

Nowy algorytm został opracowany przez Google dla jeszcze lepszego zrozumienia potrzeb użytkownika oraz samych fraz, jakie wpisuje w wyszukiwarkę.

Użytkownikowi, który wpisywał w wyszukiwarkę dość długie i precyzyjne zapytanie, w którym występowały dwa podmioty, pojawiać się mogły w wynikach wyszukiwania strony, które nie dotyczyły tego, czego szukał. Przykładowo, wpisując zapytanie „jaki komputer do pracy biurowej” przed wejściem Kolibra w wynikach wyszukiwania, mogły się pojawić ogłoszenia o pracę w biurze przy komputerze, a przecież nie o pracę biurową chodziło, tylko o sam komputer. Algorytm Koliber powoduje, iż zapytanie jest analizowane nie jako poszczególne słowa, ale sprawdzana jest również ich zależność i związek między sobą, co sprawia, że wyszukiwarka wyświetla dokładnie to, czego szukaliśmy.

Wskazówka:

Jeżeli zależy nam, aby publikowana na stronie treść zwiększała szanse pojawienia się na dane frazy kluczowe na czołowych pozycjach, powinniśmy zadbać o to, aby w treści nie tyle występowały frazy kluczowe, ale cała treść odpowiadała na wybrany temat. Treść przede wszystkim powinna być pisana dla użytkowników, a nie pod roboty sieciowe, dlatego bardzo ważne jest, aby była ona jak najbardziej użyteczna. Ponadto warto wykorzystywać w swoich treściach synonimy naszych fraz oraz ich kolokacje, które Google coraz lepiej potrafi wiązać ze sobą.

Wiele osób porównywało algorytm Koliber z aktualizacją Google Caffeine, która została wdrożona w 2010 roku. Zmiana Caffeine dotyczyła jednak przyspieszenia samej indeksacji nowych treści, a Koliber odpowiada za odpowiednie sortowanie wyników i szybkość ich wyświetlania.

Warto wspomnieć, iż Koliber to nie zwyczajna aktualizacja, ale ogólna zmiana dotychczasowo używanego przez Google algorytmu. Wprowadzenie tej zmiany zwiększyło procent dopasowań wyników do zapytań, przez co zyskały strony na frazy długiego ogona. Zmiana ta to część planowanej ewolucji wyszukiwarki Google od zwykłego zwracania stron w wynikach wyszukiwania do wykorzystywania sztucznej inteligencji.

Oprócz samego zwracania bardziej dopasowanych wyników, nowy algorytm ma na celu:

- zwiększenie nacisku na wyszukiwania lokalne,

- wyświetlanie użytkownikowi odpowiedzi na zadane przez niego pytanie już w wynikach wyszukiwania bez konieczności przechodzenia do danej strony (Knowledge Graph),

- szybsze wykrywanie spamu w wynikach,

- poprawę wyszukiwania za pomocą głosu,

- podniesienie rankingu stron na frazy długiego ogona,

- wyświetlanie lepiej dopasowanych wyników w urządzeniach mobilnych.

Koliber nie miał większego wpływu na pozycjonowanie, jednak jego zaistnienie przedstawiło nowe podejście do analizy fraz kluczowych przez algorytmy Google i tym samym wskazuje, aby kłaść duży nacisk na jakość prezentowanych treści.

Aktualizacja algorytmu Gołąb (ang. Pigeon)

Aktualizacja Gołąb (ang. Pigeon) to zmiana wprowadzana przez Google 24 lipca 2014 roku. W tym dniu Barry Schwarz jako pierwszy opisał nowy algorytm w serwisie Search Engine Land.

Wyniki wyszukiwania coraz bardziej uzależnione są od naszej lokalizacji. Obecnie, wpisując w wyszukiwarkę frazę wraz z miastem czy też bez niej, jest duża szansa, że wyniki będą się w części pokrywały. Wprowadzenie algorytmu Gołąb miało za zadanie poprawę dopasowania wyników lokalnych. Przed uruchomieniem algorytmu dana fraza wpisywana w standardowej wyszukiwarce zwracała zupełnie inne strony niż wyszukiwarka w mapach. Wprowadzenie Gołębia połączyło czynniki odpowiedzialne za ranking strony w mapach z tymi, które wyświetlają stronę w wynikach organicznych, dzięki czemu uzyskiwane wyniki były bardziej ze sobą skorelowane.

Połączenie rankingu map z organicznymi wynikami wyszukiwania poprawiło widoczność firm lokalnych, które posiadały dobrze zoptymalizowane strony właśnie pod swoją lokalizację. Od tego czasu zdecydowanie większe znaczenie w procesie pozycjonowania ma:

- umieszczanie pełnych danych teleadresowych na całej witrynie,

- rozpropagowywanie w zaufanych źródłach pełnych i spójnych danych firmy (NAP + W, ang. name, address, phone + website),

- zastosowanie na danych kontaktowych mikrodanych zgodnych ze standardem schema.org,

- utworzenie i uzupełnienie wizytówki w usłudze Google Moja Firma,

- dodanie wizytówek swojej firmy w zaufanych katalogach biznesowych typu Yellow Pages.

Wskazówka:

Jeżeli zależy nam na promocji firmy na lokalnym rynku, warto zadbać o jej widoczność w wynikach wyszukiwania, przede wszystkim dodając na stronę jak najwięcej informacji o lokalizacji, wskazówki dojazdu, godziny otwarcia, pełne dane teleadresowe oraz rejestrowe firmy, mapę Google wraz z wizytówką Google Moja Firma. Sama wizytówka w GMF powinna obejmować unikalny i użytecznych opis firmy oraz oferty, warto, by zawierała zdjęcia i filmy firmy oraz produktów. Można również wspomóc propagację informacji o firmie na serwisach społecznościowych, katalogach typu Yellow Pages oraz serwisach, na których możemy zdobyć opinie potencjalnych klientów.

Dzięki poprawieniu oceny czynników takich jak lokalizacja i odległość, wprowadzenie Gołębia w świat algorytmów Google pozwoliło również firmom, które swoją siedzibę posiadają w okolicach dużego miasta, pojawiać się na frazy właśnie z tym miastem.

Aktualizacja algorytmu Page Layout

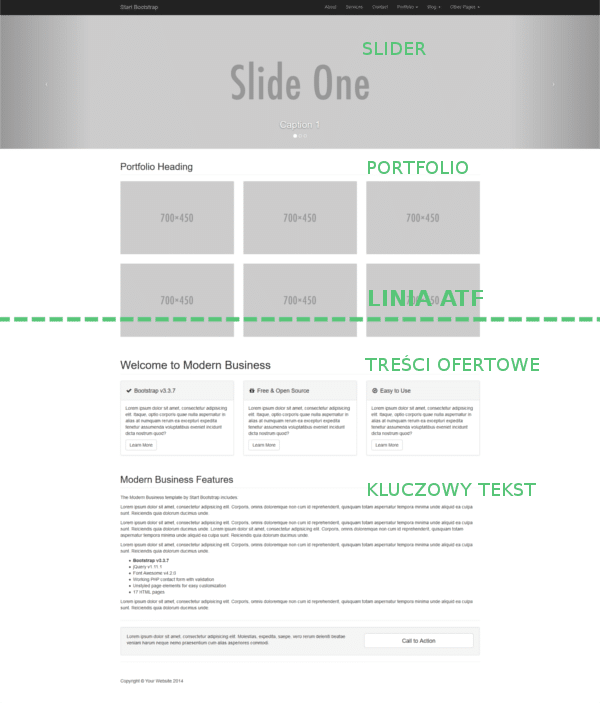

Oprócz oceny zawartości strony Google bierze pod uwagę również to, w jaki sposób i gdzie dane elementy znajdują się na stronie. Przede wszystkim bardzo ważnym miejscem na stronie, gdzie powinny się znaleźć najważniejsze informacje, jest tzw. pole nad linią załamania (ang. above the fold) – czyli miejsce widoczne zaraz po załadowaniu się strony bez przewijania jej w dół.

Nowy algorytm Google, którego zadaniem jest właśnie ocena układu strony, został wdrożony na początku 2012 roku. Pierwsza jego wersja, nazwana pierwotnie Ads Above The Fold (czyli „nadmierna ilość reklam nad treścią”), została wdrożona 19.01.2012 roku.

Celem wdrożenia tego algorytmu było obniżenie wartości stron, które prezentują swoim użytkownikom zbyt dużą ilość reklam, banerów oraz nieużytecznych elementów nad linią załamania strony. Tego typu elementy wymuszają na użytkowniku dodatkowe działania, np. przesunięcie strony w dół, aby móc otrzymać interesujące go informacje. Algorytm kontroluje to, co widzi użytkownik po wejściu na stronę, a także weryfikuje, czy tematyczne informacje znajdują się w obszarze ATF (above the fold). Jeżeli tak nie jest, strona może mieć obniżoną wartość, co negatywnie wpływa na ranking pozycji.

Poniżej zaprezentowany został przykładowy widok obszaru ATF z nadmierną ilością nieistotnych elementów oraz graniczna linia załamania strony (zielona linia przerywana).

Wielu właścicieli stron internetowych nie zdaje sobie sprawy, jak ważną rolę odgrywa miejsce widoczne zaraz po załadowaniu się strony dla użytkowników.

Często spotykamy się z sytuacją, gdzie treść z opisem firmy oraz oferty ląduje nisko w kodzie witryny, np. w stopce, a na górze strony znajduje się duża ilość reklam promocyjnych, sliderów i innych rzeczy, które zniechęcają użytkownika do zapoznania się ze szczegółami strony.

Wskazówka:

Przy projektowaniu strony internetowej należy szczególnie wziąć pod uwagę kompromis pomiędzy użytecznością strony a jej wyglądem. Oczywiste jest, że strona z samym tekstem może nie przyciągnąć uwagi użytkownika, ale też, z drugiej strony, same zdjęcia i reklamy mogą tylko odstraszyć użytkownika. Optymalnym rozwiązaniem jest zaprojektowanie obszaru ATF w taki sposób, aby znalazła się w niej główna nawigacja serwisu, główny content, a przynajmniej jego większa część, oraz informacje o firmie, np. pole „Szybki kontakt”. Im szybciej użytkownik, który znajdzie się na naszej stronie, znajdzie poszukiwane informacje, tym większa jest szansa, że zostanie na stronie dłużej i skorzysta z oferty.

Kolejnymi elementami, które algorytm bierze pod uwagę, są:

– blokada mediów w pliku robots.txt

Jeżeli w pliku robots.txt media, które prezentujemy na stronie (np. zdjęcia, pliki CSS i JS), są zablokowane, roboty sieciowe nie są w stanie prawidłowo renderować strony i tym samym prawidłowo ocenić jej układu. Przykładowym systemem CMS, który domyślnie blokuje elementy szablonu strony, jest popularny system Joomla. Warto więc zweryfikować, np. przy pomocy narzędzia Pobierz jako Google w usłudze Google Search Console, w jaki sposób stronę widzi użytkownik, a w jaki robot.

– responsywność strony

Skalowanie się strony do urządzeń mobilnych lub też ich mobilna, osobna wersja to w obecnych czasach standard przy tworzeniu nowych stron internetowych. W sieci widnieje jednak jeszcze bardzo duża ilość stron, które nie są przystosowane do urządzeń mobilnych a co za tym idzie – mogą być tworzone dla wybranych rozdzielczości ekranu. Warto zweryfikować, np. przy pomocy narzędzi do testowania responsywności dostępnych w Internecie, jak np.: test-zgodnosci.pl, jak strona wygląda na różnych przeglądarkach oraz w różnych rozdzielczościach. Może się okazać, iż nasza strona prawidłowo się wyświetla na jednej niestandardowej rozdzielczości, a na innej treść już będzie trudniej dostępna.

Algorytm Page Layout doczekał się swoich dwóch aktualizacji. Pierwsza miała miejsce 9 października 2012 roku, lecz niestety nie zdradzono szczegółów zmian, jakie zastosowano. Druga aktualizacja nastąpiła 6 lutego 2014 roku. Google odświeżyło algorytm, zaostrzając ocenę obszaru ATF i biorąc pod uwagę dodatkowe elementy, które mogą przysłaniać kluczowe informacje.

Aktualizacja algorytmu Pirat (ang. Pirate)

Algorytm Pirat (ang. Pirate) został stworzony 10 sierpnia 2012 roku i jego głównym zadaniem było usunięcie z wyników wyszukiwania stron, które udostępniały materiały chronione prawami autorskimi, co również w wielu krajach jest niezgodne z prawem. Google uznało piractwo za nieetyczne, dlatego przyłożyło się do walki z serwisami, które umożliwiały pobranie nielegalnych plików. Głównie chodziło o filmy, muzykę i oprogramowanie, chociaż Google obniżyło ranking również tym witrynom, które posiadały odnośniki do stron, gdzie można było pobrać nielegalne treści lub były pośrednikiem, np. torrenty.

Pirat umożliwia właścicielom praw autorskich zgłaszanie udostępnionych materiałów do usunięcia z indeksu Google. Algorytm po przyjęciu takiego zgłoszenia sprawdza wskazaną podstronę oraz udostępniany materiał i jeżeli uzna adres za naruszający prawa autorskie, usuwa go z wyszukiwarki Google.

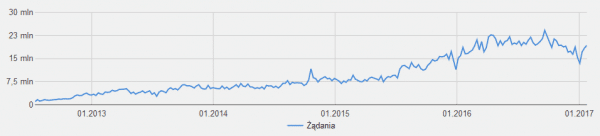

Google przed uruchomieniem tego algorytmu otrzymywało bardzo dużą ilość żądań usunięcia danych materiałów ze swojego indeksu i stąd wynikła potrzeba utworzenia takiego algorytmu. Liczba żądań usunięcia danych stron po uruchomieniu nowego algorytmu tylko rosła.

Firma wyraźnie podkreśla, iż zależy jej na tym, aby prawa autorskie były przejrzyste, dzięki czemu wszyscy będą wiedzieć, jaki wpływ mają prawa autorskie na dostępność treści.

Poniższy wykres prezentuje liczbę żądań usunięcia materiałów z sieci od wejścia algorytmu w życie do chwili obecnej.

Źródło: Google Tranparency Report

Wskazówka:

Algorytm Pirat został utworzony głównie w celu walki z masowym piractwem nielegalnych materiałów. Nie jest jednak powiedziane, że jego działanie nie dotyczy serwisów, które nie udostępniają nielegalnych materiałów. Samo kopiowanie treści i zdjęć z innych serwisów czy też powielona oferta, oprócz negatywnego zjawiska jakim jest „duplicate content”, może również być źle odbierane przez Pirata. Zalecane jest prezentowanie na swojej stronie tylko unikalnych materiałów lub ewentualnie treści za zgodą ich właścicieli.

Algorytm Pirat doczekał się również swojej drugiej wersji, bowiem 21.09.2014 roku, tuż po Pingwinie 3.0, wyszła jego aktualizacja. Zmiany w algorytmie prawdopodobnie dotyczyły zwiększenia wartości ilości zgłoszeń na daną stronę, dzięki czemu algorytm jest bardziej „czuły” i już mała ilość zgłoszeń może wystarczyć, aby dana strona została usunięta z wyników wyszukiwania lub znacząco obniżona w rankingu.

Dzięki temu algorytmowi z pewnością zyskali właściciele praw autorskich, których materiały są wreszcie chronione.

Aktualizacja algorytmu Payday Loan

Google, podobnie jak w przypadku nielegalnych materiałów, nieustannie podejmuje walkę ze spamem oraz z niezgodnymi z ich polityką technikami zwiększenia widoczności strony. W tym celu 11 czerwca 2013 roku Google wypuściło aktualizację Payday Loan. Głównym celem tego algorytmu było obniżanie wartości stronom, które wykorzystywały w dużej ilości spam na innych witrynach. Najczęściej były to branże finansowe udzielające pożyczki oraz pornograficzne. Wejście w życie tego algorytmu zaowocowało m.in. obniżeniem wartości stron m.in. dla 4% tureckich zapytań, kierujących do stron z pożyczkami, pornografią czy posiadających spamerskie treści (według Matta Cuttsa zapytania dotyczące spamerskich treści w Turcji są bardzo liczne).

16 maja 2014 roku w życie weszła druga wersja – Payday Loan 2.0. Nowa wersja algorytmu pojawiła się tuż przed premierą Pandy 4.0, jednak według informacji od Google algorytm ten nie jest w żaden sposób powiązany z Pandą czy Pingwinem. Aktualizacja ma na celu trafiać głównie w bardzo zaspamowane strony.

Trzecia odsłona tego algorytmu, oznaczona jako Payday Loan 3.0, została wypuszczona 12 czerwca 2014 roku. Zasadniczą różnicą tej wersji od poprzedniej jest to, iż wersja 2.0 ukierunkowana była na strony z bardzo agresywnym spamem na stronie, natomiast w wersji 3.0 uwzględnione zostały również spamerskie zapytania. Na celownik zostały wzięte zapytania związanie z takimi frazami jak np.: „chwilówki”, „pożyczki” czy „viagra”.

Zaostrzenie się tego algorytmu powinno całkowicie wyeliminować z wyników wyszukiwania strony, które są zlepkiem połączonych ze sobą fraz kluczowych i tym samym powinny poprawić pozycje witrynom, które są w naturalny sposób zoptymalizowane.

Aktualizacja algorytmu Mobilegeddon

Wraz ze wzrostem popularności urządzeń mobilnych strony internetowe coraz częściej dostosowywały swój układ właśnie na mniejsze urządzenia przenośne. Tworzenie responsywnych stron internetowych, które dopasowują wygląd do popularnych rozdzielczości ekranów, a także osobne wersje mobilne powoli zaczęły być standardem. Google, dbając o swoich użytkowników, chciało nagrodzić administratorów, którzy zadbali o użyteczność swojej witryny i posiadają wersję mobilną.

W tym celu 21 kwietnia 2015 roku Google wypuściło na świat nową aktualizację algorytmu zwaną Mobile Update lub Mobilegeddon, która już od następnego dnia traktowała lepiej strony dostosowane do urządzeń mobilnych. Sama nazwa „Mobilegeddon” powstała na skutek spodziewania się wielkich zmian w wynikach wyszukiwania za sprawą wejścia tego algorytmu w życie, jednak w rzeczywistości nie były one gwałtowne. Strony, które posiadały mobilną wersję, odnotowały delikatne plusy w rankingu, wyprzedzając te, które takiej wersji nie posiadały. Google już znacznie wcześniej zachęcało właścicieli do przystosowania swoich stron na urządzenia przenośne, przypisując do strony w wynikach wyszukiwania napis „Mobile-friendly”.

Wskazówka:

Obecnie responsywność strony lub ewentualnie osobna wersja mobilna to standard przy tworzeniu stron internetowych. Jeżeli zależy nam na uzyskaniu wysokich pozycji w organicznych wynikach mobilnych, zdecydowanie warto zadbać o to, aby strona była w pełni przystosowana do urządzeń mobilnych. Należy zatem przy pomocy narzędzia Google Test optymalizacji mobilnej zweryfikować, czy wszystkie elementy naszej strony są przystosowane na małe ekrany i tym samym, czy strona jest w 100% mobilna.

Algorytm doczekał się swojej nowej wersji 12 maja 2016 roku – znana jest jako Mobile-friendly 2. Google wraz z wdrożeniem nowej wersji algorytmu chce poniekąd wymusić na użytkownikach dostosowanie swoich stron do urządzeń mobilnych i tym samym obniżyć wartość tym witrynom, których właściciele jeszcze tego nie zrobili. Zastosowanie takiej praktyki przez Google jest dość restrykcyjne, jednak wytłumaczone tym, iż ruch mobilny powoli wyprzedza ruch na urządzeniach desktopowych. Patrząc na to, jak Google dba o swoich użytkowników, takie pogonienie „leniwych” właścicieli stron ma sens.

Pozostałe zmiany w algorytmach Google

Oprócz opisanych powyżej zmian w algorytmach Google wprowadziło dużą ilość innych ciekawych udoskonaleń. Z tych bardziej znaczących, o których było głośno w sieci, możemy wymienić:

Boston

Ogłoszona podczas amerykańskiej konferencji Search Engine Strategies w lutym 2003 roku pierwsza udokumentowana aktualizacja algorytmu Google. Ze względu na trwający tzw. Google Dance o aktualizacji szybko zapomniano na rzecz kolejnych zmian.

Cassandra

Algorytm, który jako pierwszy rozpoczął walkę z nadmiernym linkowaniem domeny oraz niezgodnymi z wytycznymi Google praktykami optymalizacji serwisu, np. ukrywania treści. Wdrożony został w kwietniu 2003 roku. Wiele stron po wdrożeniu tego algorytmu utraciło swoje pozycje.

Dominic

Wdrożona w maju 2003 roku aktualizacja Dominic wpłynęła na metodę zliczania oraz oceny backlinków. Zmiana ta miała duży wpływ na wyniki zapytań, obniżając ranking wielu serwisom.

Esmeralda

Aktualizacja Esmeralda wdrożona w czerwcu 2003 roku miała wpływ na wyniki wyszukiwania, jednak jej szczegóły są nieznane. Miała być też ostatnią aktualizacją z comiesięcznych cyklicznych zmian w algorytmie Google.

Fritz

Wdrożona w lipcu 2003 roku aktualizacja o nazwie Fritz zmieniła częstotliwość zmian w algorytmie. Comiesięczny „Google Dance” dobiegł końca. Od tego czasu indeks Google zmieniany był każdego dnia.

Supplemental Index

Google z jednej strony chce indeksować jak najwięcej informacji, ale z drugiej strony chce także zachować jakość wyświetlanych wyników. Z tego powodu we wrześniu 2003 roku wprowadzony został indeks uzupełniający, który po dodatkowym kliknięciu na końcu wyników organicznych wyświetla pozostałą część wyników mogącą powielać informacje lub posiadać niską wartość. Pojawienie się strony w Supplemental Index jest też wskazówką, że strona nie jest uznawana jako wartościowa i warto o nią lepiej zadbać.

Florida

Google wdrożyło w listopadzie 2003 roku aktualizację Florida, która przyniosła ogromne zmiany w wynikach wyszukiwania. Wiele witryn utraciło swoje pozycje w TOP10, a właściciele firm byli bardzo oburzeni. Floryda zaostrzyła walkę z niestosownymi praktykami SEO z lat 90-tych, jak np. upychaniem słów kluczowych.

Austin

Zmiana o nazwie Austin nastąpiła w styczniu 2004 roku. Aktualizacja była dopracowaniem tego, czego brakowało przy zmianie Florida. W dalszym ciągu ukrywanie treści czy upychanie słów kluczowych mocno obniżało ranking stron.

Brandy

Wdrożony w maju 2004 roku algorytm Brandy wpłynął znacząco na ocenę dopasowania anchor tekstów – zwiększając nacisk na ich jakość, znaczenie i korelację synonimów.

Nofollow

Atrybut nofollow, który zyskał popularność w branży SEO, został zapoczątkowany w okolicach 18 stycznia 2005 roku. Jego celem jest umożliwienie większej kontroli linków wychodzących ze stron. Google wspólnie z Microsoftem i Yahoo ustalili, że ich wyszukiwarki będą rozpatrywać przy linkach ten atrybut zapisany jako rel=”nofollow”. Wdrożenie tego atrybutu przy odnośniku ma uniemożliwiać przenoszenie wartości do innych stron.

Personalized Search

W czerwcu 2005 roku Google wprowadziło do swojej wyszukiwarki spersonalizowane wyszukiwanie. Google przy pomocy historii wyszukiwania danego użytkownika automatycznie wyświetla w wynikach wyszukiwania strony, które najbardziej mogą odpowiadać danemu użytkownikowi lub na które często już wchodził. Obecnie historię wyszukiwania można w dowolnym momencie wyłączyć w ustawieniach wyszukiwarki Google, a będąc zalogowanym, na stałe zapisać takie ustawienia.

Big Daddy

Zmiana Big Daddy, która odbyła się w grudniu 2005 roku, techniczne rzecz ujmując była aktualizacją infrastruktury (podobnie jak przy Caffeine). Zmiana wpłynęła na ocenę adresów URL oraz przekierowań tymczasowych typu 302 i stałych 301.

Universal Search

W maju 2007 roku weszło w życie uniwersalne wyszukiwanie. Nie była to jednak zwyczajna aktualizacja, gdyż mocno wpłynęła na użyteczność samej wyszukiwarki. Oprócz samych stron internetowych, w zależności od zapytania użytkownik mógł ujrzeć w wynikach wyszukiwania również zdjęcia, wideo, aktualności oraz wiadomości.

Google Suggest

W sierpniu 2008 roku wprowadzona została jedna z dużych zmian na stronie wyszukiwarki. Google podczas wpisywania w pole tekstowe frazy zaczęło podpowiadać propozycje fraz kluczowych na podstawie wpisywanych słów. Był to kolejny krok Google ku użyteczności wyszukiwarki i przyspieszeniu wyszukiwania informacji.

Caffeine

Wdrażana przez dłuższy okres (od sierpnia 2009 do czerwca 2010) zmiana Caffeine to nowa infrastruktura Google, która poprawia i odświeża indeks wyszukiwarki o 50%.

May Day

Od 28 kwietnia do 3 maja 2010 roku można była zauważyć liczne spadki na frazy długiego ogona. Jak się okazało, miała wówczas miejsce aktualizacja algorytmu, której skutki odczuły przede wszystkim sklepy internetowe, najbardziej wykorzystujące ruch z długiego ogona.

Social Signal

Matt Cutts potwierdził w grudniu 2010 roku, że Google, podobnie jak wyszukiwarki Bing, zaczął brać pod uwagę serwisy społecznościowe przy rankingu strony – w tym serwisy Twitter i Facebook. Było to stosunkowo nowe rozwiązanie dla Google, chociaż w świecie SEO już od dawna wyczekiwane.

Schema.org

W czerwcu 2011 roku firma Google wraz z konkurencją taką jak Yahoo i Microsoft ogłosiły zastosowanie wspólnego schematu danych strukturalnych. W serwisie schema.org mamy do dyspozycji pełną dokumentację schematów znaczników, które zaczęły być wspierane przez wyszukiwarki. Mikrodane nakładane na poszczególne elementy serwisu ułatwiają wyszukiwarkom prawidłowe zinterpretowanie znajdujących się w nich informacji.

Query Encryption

18 października 2011 roku Google ogłosiło, że wyniki wyszukiwania od teraz będą szyfrowane ze względu na ochronę prywatności. Zmiana ta spowodowała ukrycie części statystyk ruchu na stronie, oznaczając ruch ze słów kluczowych jako „not provided”. Liczba tego typu komunikatów w ciągu kilku tygodni bardzo szybko wzrosła. Sytuacja ta nie zmieniła się do dzisiaj.

Search + Your World

10 stycznia 2012 roku Google ogłosiło dużą zmianę w personalizacji wyników wyszukiwania, które zaczęły prezentować na liście profile użytkowników z serwisu społecznościowego Google+. Oczywiście opcja ta jest do wyłączenia przy własnym profilu. Przy wpisywaniu w wyszukiwarce imienia i nazwiska, Google rozpocznie podpowiadanie począwszy od nazwisk, które znajdują się w naszych kręgach znajomych.

Wenecja

Uruchomiony 27 lutego 2012 roku algorytm Wenecja (ang. Venice) wpłynął na wyświetlanie wyników wyszukiwania, korelując je z lokalizacją użytkownika. Do tej pory wyniki były połączone wyłącznie z mapami, natomiast algorytm Wenecja wprowadził bardziej lokalny charakter wszystkich zapytań bez względu na mapy.

Knowledge Graph

Google wprowadziło w dniu 16 maja 2012 roku „Graf wiedzy” (w dosłownym tłumaczeniu), który w osobnym polu przy wynikach organicznych wyświetlał potwierdzone informacje o wyszukiwanej osobie, miejscu czy firmie. Knowledge Graph jest obszerną bazą wiedzy, która na celu ma poprawienie użyteczności wyszukiwarki, aby możliwie najszybciej zaprezentować użytkownikowi informacje, których poszukuje.

Na początku grudnia 2012 roku Google rozbudowało swój graf do innych języków niż tylko angielski. Nie były to jednak wszystkie kraje. Język polski został wprowadzony dopiero po roku, w maju 2013.

Exact-Match Domain Update

Wdrożenie 27 września 2012 roku tej aktualizacji spowodowało spadek wielu domen, które w swojej nazwie posiadały frazy kluczowe, tzw. Exact-Match Domain. Zmiana miała wpływ na ok. 2,4% zapytań. Google w swoim algorytmie ocenia, czy domena została wykupiona, aby poprawić ranking pozycji, czy nazwa w niej zawarta jest skorelowaną z nazwą firmy. Do zwiększenia szansy, aby strona nie została ukarana, warto było posiadać wizytówki strony na portalach społecznościowych oraz udzielać się na nich.

Phantom

W okolicach 9 maja 2013 roku przez odnotowanie sporych spadków pojawiły się wzmianki o nowej aktualizacji. Niestety szczegóły tej aktualizacji nie wyszły na światło dzienne. Google do aktualizacji się oficjalnie nie przyznało, wciąż potwierdzając jedynie, że zmiany są wprowadzane bardzo często. Specjaliści odnotowali prawdopodobnie drugą odsłonę tej aktualizacji tuż po wdrożeniu The Quality Update około maja 2015. 19 listopada rzekomo wdrożony został Phantom 3.

Domain Crowding

Google, dążąc do dywersyfikacji wyników wyszukiwania, wprowadziło 21 maja 2013 roku aktualizację, która miała na celu usunięcie z wyników wyszukiwania powtarzające się te same domeny. Wiele serwisów odnotowało wówczas wzrosty, a tak naprawdę przesunięcie się o zwolnioną ilość miejsc w górę. Matt Cutts poniekąd potwierdził wejście w życie tego algorytmu, mówiąc o działaniach na rzecz eliminowania „stłoczonych domen”.

HTTPS/SSL Update

6 sierpnia 2014 roku na blogu Google ogłoszona została aktualizacja algorytmu, która jako kolejny czynnik rankingujący będzie brała certyfikat SSL. Google, dbając o swoich użytkowników, chce im zapewnić bezpieczeństwo w Internecie, dlatego wdrażając tę zmianę w swoim algorytmie, chce zachęcić właścicieli do wykupowania certyfikatów, które potwierdzałyby szyfrowane – czyli bezpieczne przeglądanie strony.

Zastosowanie protokołu HTTPS jest wskazane szczególnie dla sklepów internetowych lub podstron z formularzami, gdzie użytkownik przesyła do serwera swoje poufne informacje.

Dostępność strony pod protokołem HTTPS daje bonus domenie w rankingu Google niezależnie od tego, czy zastosowano go na całej domenie, czy tylko na niektórych podstronach.

Authorship Removed

Google, wdrażając w wynikach wyszukiwania informacje o autorze, chciało zwiększyć tym samym użyteczność swojej wyszukiwarki. Niestety okazało się, że tak nie było. Mając na uwadze opinie użytkowników, z dniem 28 sierpnia 2014 roku Google wprowadziło zmianę o nazwie Authorship Removed, która polegała na zaprzestaniu pokazywania informacji o autorze. Google również poinformowało, iż wykonało test po tej zmianie i usunięcie informacji o autorze nie wpłynęło znacząco na klikalność danych witryn.

The Quality Update

Na majówkę 2015 roku Google zaserwowało nową aktualizację algorytmu o nazwie The Quality Update. Zmiana z początkiem maja spowodowała spore rotacje w wynikach. Szczegóły zmian nie są do końca znane, jednak wiadomo, że przekształceniu uległ główny algorytm wyszukiwarki w celu ogólnego zwiększenia jakości ocenianych stron.

RankBrain

26 października 2015 roku Google oficjalnie poinformowało, że od kilku miesięcy częścią algorytmu Koliber była wdrożona sztuczna inteligencja nazwana RankBrain. Co ważne, RankBrain jest trzecim najważniejszym czynnikiem, który jest brany pod uwagę przy ocenie serwisu i wskazywaniu jego miejsca w rankingu. Google nie ujawnia, jakie dwa inne czynniki są od niego ważniejsze. Do tej pory za wszelkimi aktualizacjami i dostosowaniem algorytmów Google stali inżynierowie. RankBrain opiera swoje działanie na semantyce, analizując ciągle wpisywane w wyszukiwarkę frazy, szuka korelacji między nimi i w ten sposób się uczy oraz zapisuje coraz większą ilość informacji, dzięki czemu witryny są lepiej oceniane pod kątem tematyczności.

Possum

Grono zwierzaków w algorytmach Google ponownie się zwiększyło, przyjmując 1 września 2016 roku na swój pokład Oposa (ang. possum). Ten mały futrzak spowodował sporo zamieszania przy lokalnych wynikach wyszukiwania. Algorytm Opos wpłynął pozytywnie na firmy, które promują się na konkretną lokalizację, pomimo tego, iż sami znajdują się w jej okolicy, a nie w konkretnym mieście. Dodatkowo lokalizacja użytkownika jeszcze mocniej przekłada się na pojawiające się w TOP10 wyników. Zmianie uległ też tzw. 3-pack z trzema wynikami map w wynikach organicznych, w którym mocniej zróżnicowano pojawiające się w nim wizytówki. Zmiana algorytmu sugeruje wszystkim administratorom stron nałożenie większego nacisku na optymalizację wizytówki w usłudze Google Moja Firma oraz samej strony www pod kątem wskazania lokalizacji.

Google Intrusive Interstitials Mobile Penalty

Google 10 stycznia br. oficjalnie potwierdziło aktualizację algorytmu, która będzie nakładała kary tym serwisom, które utrudniają użytkownikom dostęp do tematycznych treści na wersjach mobilnych przez pojawiające się pełnoekranowe reklamy (tzw. popupy). Firma informowała o takim planie już około rok temu. Jeżeli użytkownikowi, który wszedł na mobilną stronę z wyników wyszukiwania na pierwszym planie wyskoczy okno z reklamą, wówczas taka strona najprawdopodobniej prędzej czy później otrzyma karę. Zastosowanie reklam w innej formie na stronie mobilnej zmniejsza ryzyko tego działania, jednak w dalszym ciągu może znacząco wpływać na pozycje strony. Z tego względu warto ustrzec się przed tym algorytmem i oczyścić mobilną wersję strony ze zbędnych reklam.

Podsumowanie

Opisane powyżej aktualizacje pokazują nam, jak wielką metamorfozę przeszły algorytmy Google od początku istnienia tej firmy. Chcąc zaprezentować historię algorytmów, poniekąd przedstawiona została historia samej firmy, ponieważ zaobserwować możemy zmiany podejścia Google do wielu kwestii sieciowych.

Pokazane zostały oczywiście tylko te zmiany, które Google oficjalnie i nieformalnie potwierdziło w swoich komunikatach o danych zmianach oraz te, które specjaliści SEO sami zauważyli – przede wszystkim po pojawieniu się różnic w wynikach wyszukiwania. Możemy sobie tylko wyobrazić, ile drobnych zmian niesie ze sobą każda wspomniana aktualizacja czy też ta, która nie była zauważona w branży SEO. Tak duża ilość zmian oraz setki różnych czynników rankingujących w algorytmach Google sprawiają, że osoba, która jest świadoma wymogów Google, zupełnie inaczej podchodzi do jakiekolwiek czynności wykonanej na swojej stronie internetowej.

Jesteśmy na bieżąco z aktualizacjami algorytmów, a kolejne staramy się wyprzedzać zawsze o krok. Potrzebujesz pomocy?

Od samego początku istnienia Google najrozsądniejszym sposobem, aby uzyskiwać czołowe pozycje w rankingu, było postępowanie zgodnie z oficjalnymi zaleceniami. Jakiekolwiek działania niezgodne z wytycznymi tej firmy, które pozwoliły stronie wybić się do TOP10 i tym samym ominąć surową ocenę algorytmów, prędzej czy później przestaną działać, gdyż – jak widzimy – Google nie spoczywa na laurach zaawansowanej technologii, jaką posiada, oraz tego, iż jest liderem na rynku. Nieustannie udoskonala swoje produkty, aby w TOP10 pojawiały się wyłącznie serwisy, które naprawdę na to zasługują.

Wypełnij formularz

Przygotujemy dla Ciebie bezpłatną wycenę!

Dodatkowo otrzymasz bezpłatnie dostęp do kursów z marketingu internetowego.