Spadające pozycje serwisu w wynikach wyszukiwań to najgorszy koszmar każdego specjalisty SEO, a jednocześnie zjawisko w swojej istocie bardzo popularne i naturalne, którego charakter wynika wprost ze specyfiki branży. Jak należy reagować, kiedy obserwujemy spadki widoczności w naszym serwisie?

Dlaczego pozycje w ogóle spadają?

Spadki widoczności są zawsze postrzegane negatywnie – nic dziwnego, przecież oznacza to, że ze stroną dzieje się coś złego, co koniecznie należy sprawdzić i naprawić! Jest to źródło frustracji i stresu, zwłaszcza kiedy nie wiemy, czym te spadki są spowodowane. W takich sytuacjach należy zachować spokój i podejść do tematu metodycznie. Pierwsza rzecz, którą należy określić to: czy spadki, które widzisz, są potencjalnie zależne czy niezależne od działań na stronie? Odpowiadając na to pytanie, jesteś w stanie odpowiednio podejść do problemu i znaleźć rozwiązanie. Jakie przyczyny spadków określamy jako niezależne od nas?

Spadki ze względu na algorytm Google

Wahania widoczności są nieuniknione. Google aktualizuje swój algorytm codziennie, ale informuje nas o większych zmianach jedynie raz na kilka miesięcy. Algorytm wyszukiwarki, mając na celu ciągłe doskonalenie jakości wyników wyszukiwania, może różnie wpływać na widoczność serwisu. Pierwsza zasada więc brzmi: jeśli zauważasz wahania widoczności na wykresie – nie panikuj. Dowiedz się, czy były jakieś znaczące zmiany w działaniu algorytmu w ostatnim czasie. Jeżeli tak – postępuj zgodnie z najnowszymi zaleceniami od Google w pierwszej kolejności dla podstron, które spadły w pozycjach najmocniej. Skrupulatne podejście może zaowocować większą odpornością na zmiany w algorytmie w przyszłości. Wynika to z faktu, że strony zaniedbane pod kątem SEO po prostu mocniej tracą na pozycjach.

Czy jest jakiś sposób na uodpornienie się na zmiany w algorytmie? Generalnie rzecz biorąc – nie. Analizując natomiast kierunek, w którym podąża algorytm, można wywnioskować, że zawsze należy dbać o:

- dobrej jakości treść,

- przejrzystą strukturę linkowania,

- szybkie ładowanie witryny,

- dostosowanie pod mobile.

Jeśli zadbasz o te podstawy, Twoja witryna będzie trochę bardziej odporna na zmiany w algorytmie. A być może nawet na nich zyska ;)

Spadki ze względu na konkurencję

Zwykle wiąże się to z niewielkim spadkiem w rankingach. W pewnym momencie, wpisując określoną frazę, zobaczysz witrynę konkurencji w górnych wynikach, gdzie kiedyś była Twoja witryna. Jak zidentyfikować przyczynę, dla której konkurencja jest wyświetlana „wyżej” w SERP-ie? Przede wszystkim należy brać pod uwagę, że konkurencja prawdopodobnie również inwestuje w SEO i rozwija swój serwis. Dlatego ważne jest, aby stale monitorować ich działania i dostosowywać zmiany na naszej witrynie w odpowiedzi na spadki określonych fraz.

Czy da się jakoś uchronić przed wyprzedzeniem przez konkurencję? Tylko poprzez ciągłe rozwijanie własnej strony oraz obserwację działań bezpośrednich konkurentów – m.in. ich profilu linkowego, ilości i jakości treści oraz struktury linkowania wewnętrznego.

Spadki z powodu ataku hakerskiego lub wirusa

W tym przypadku musimy się martwić nie tylko o pozycje, ale także o bezpieczeństwo danych wrażliwych. Niemniej jednak nie każdy atak powoduje wyłączenie serwisu i utratę danych. Zdarzają się „ukryte” ataki hakerskie mające na celu wykorzystanie witryny w celu przykładowo szerzenia spamu lub polepszenie pozycji dla innej witryny. Serwisy, które padają ofiarami ataku hakerskiego lub wirusa, bardzo często są wykluczane z indeksu wyszukiwarek, co siłą rzeczy zeruje widoczność serwisu w internecie. W tym przypadku należy przede wszystkim usunąć zagrożenie hakerskie i oczyścić serwis ze spamerskich linków, komentarzy itd. Po usunięciu skutków włamania należy zgłosić serwis do ponownej weryfikacji w Google.

Spadki pozycji ze względu błędy optymalizacyjne

Są rzeczy w SEO, na które mamy wpływ, i to właśnie one są najczęstszą przyczyną wahań widoczności w serwisie. Jak należy postępować, kiedy pozycje serwisu nagle spadają lub słabną?

1. Sprawdź kody odpowiedzi witryny

Ciężko o dobre pozycje dla podstron zwracających kod błędu 404. Pojedyncze podstrony zwracające ten kod negatywnie wpływają na także na widoczność całego serwisu, w tym na podstrony z kodem 200. Dzieje się tak, ponieważ 404 ogranicza możliwość crawlu dla botów wyszukiwarek, dzięki czemu opuszczają one witrynę, nie skanując reszty serwisu lub jakiejś jego części. Niekorzystnie wpływa na widoczność też duża liczba przekierowań, która powoduje, że crawl budget wyczerpuje się, zanim bot zeskanuje wszystkie podstrony zawarte w serwisie. Reasumując – upewnij się, że możliwie wszystkie URL serwisu zwracają kod 200.

2. Upewnij się, że bot ma dostęp do serwisu

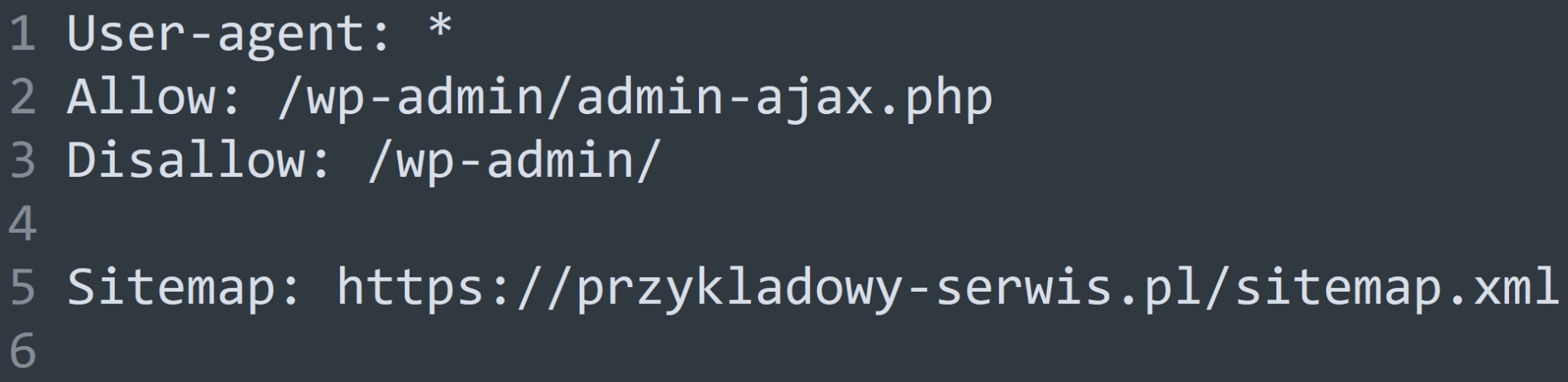

Zacznij od sprawdzenia pliku robots.txt. Jest to plik tekstowy znajdujący się w głównym katalogu serwisu na serwerze, który zawiera instrukcje dla robotów. Pozwala on na kontrolowanie interakcji botów z serwisem i określania dla nich dostępu do wybranych podstron lub katalogów. Jeżeli w pliku robots.txt masz ustawione ograniczenie na „wejście” dla robotów dla całego serwisu albo ważnych podstron, uniemożliwi to skanowanie i następnie indeksowanie serwisu. Czasami dzieje się tak z powodu małego błędu – na przykład przy działaniu, które miało ograniczyć tylko wyniki filtrów, ograniczamy dostęp do wielu istotnych z punktu widzenia zasobów. Polecam więc sprawdzić komendy zawarte w tym pliku albo skorzystać z darmowych narzędzi pozwalających na szybką weryfikację pliku robots.txt.

Źródło: Przykładowy plik tekstowy

3. Sprawdź najważniejsze elementy podstawowej optymalizacji SEO

Podstawy SEO mają największy wpływ na widoczność każdego serwisu. Dlatego rekomenduję również sprawdzenie wszystkich metatagów witryny pod kątem braków w optymalizacji. Zwróć też uwagę na ich długość – za długą treść w title i meta description należy skrócić. Czy masz zoptymalizowane wszystkie tytuły, począwszy od strony głównej, oraz czy wyświetlają się one poprawnie w SERP? Niewystarczająco zwięzła treść w znacznikach title z pewnością będzie miała negatywny wpływ na ranking serwisu. Znaczniki meta description oficjalnie nie wpływają na pozycje witryny, ale z własnego doświadczenia wiem, że zoptymalizowane działają korzystnie na indeksację poszczególnych podstron. Jak stosujesz nagłówki H1? Na każdej podstronie może być tylko jeden nagłówek H1, który zawiera treść opisującą zawartość podstrony. Sprawdź zatem, czy na każdej podstronie są tytuły, metaopisy i nagłówki H1 oraz jaka treść w nich jest zawarta.

4. Sprawdź Google Search Console

Google Search Console zawiera dużo cennych informacji na temat Twojego serwisu oraz jego kondycji. Należy więc obowiązkowo sprawdzić te narzędzie pod kątem ostrzeżeń lub błędów indeksacji oraz wprowadzić niezbędne poprawki. Sprawdź także, czy została prawidłowo wczytana mapa witryny. W oknie mapy witryny możesz również sprawdzić, ile adresów URL zostało odczytanych z mapy witryny, i porównać, czy ta liczba zgadza się z liczbą podstron serwisu w indeksie Google. Aby zobaczyć, ile podstron aktualnie jest zaindeksowanych w Google, wpisz komendę site:nazwadomeny.pl w polu wyszukiwania, albo zeskanuj serwis za pomocą dowolnego crawla. Po usunięciu przeszkód w prawidłowej indeksacji serwisu należy zgłosić weryfikację indeksacji w GSC. Najważniejsze podstrony serwisu rekomenduję zgłaszać osobno poprzez wpisanie ich adresów w górnym polu wyszukiwania w narzędziu. Bardzo przydatna jest także funkcja powiadomień mailowych z GSC, dzięki czemu w razie wystąpienia problemów z kondycją domeny lub indeksacją dostaniesz odpowiednią informację.

Mimo że algorytmy mogą być nieprzewidywalne, Google w swoim narzędziu jasno określa, czego oczekuje od Twojej witryny. Postępuj zgodnie z wytycznymi, a na pewno przełoży się to na pozycje w wynikach wyszukiwania i ich „stabilność”.

5. Sprawdź Google Analytics

Wahania widoczności nie są groźne same w sobie, gdyż jedynie odzwierciedlają pozycje serwisu na określone frazy. Ważny jest ruch, który te frazy generują. I to właśnie spadek ruchu jest najgroźniejszy w kontekście utraty pozycji. Dzięki Google Analytics sprawdzisz najważniejsze metryki i dowiesz się, czy w określonym okresie nastąpił spadek ruchu. Dodatkowo dzięki temu narzędziu możesz zweryfikować wpływ spadków na inne metryki, takie jak: współczynnik odrzuceń, czas spędzony na stronie i inne. Jeżeli dokonałeś jakichś większych zmian na stronie, metryki Google Analytics z pewnością to odnotują. Dzięki temu jesteś w stanie lepiej zrozumieć, co mogło wpłynąć na spadek pozycji i w jakim kierunku należy iść, aby je odbudować. Aby wyciągnąć jeszcze więcej informacji, podziel użytkowników na tych, którzy korzystają z przeglądarki w wersji desktopowej i mobilnej.

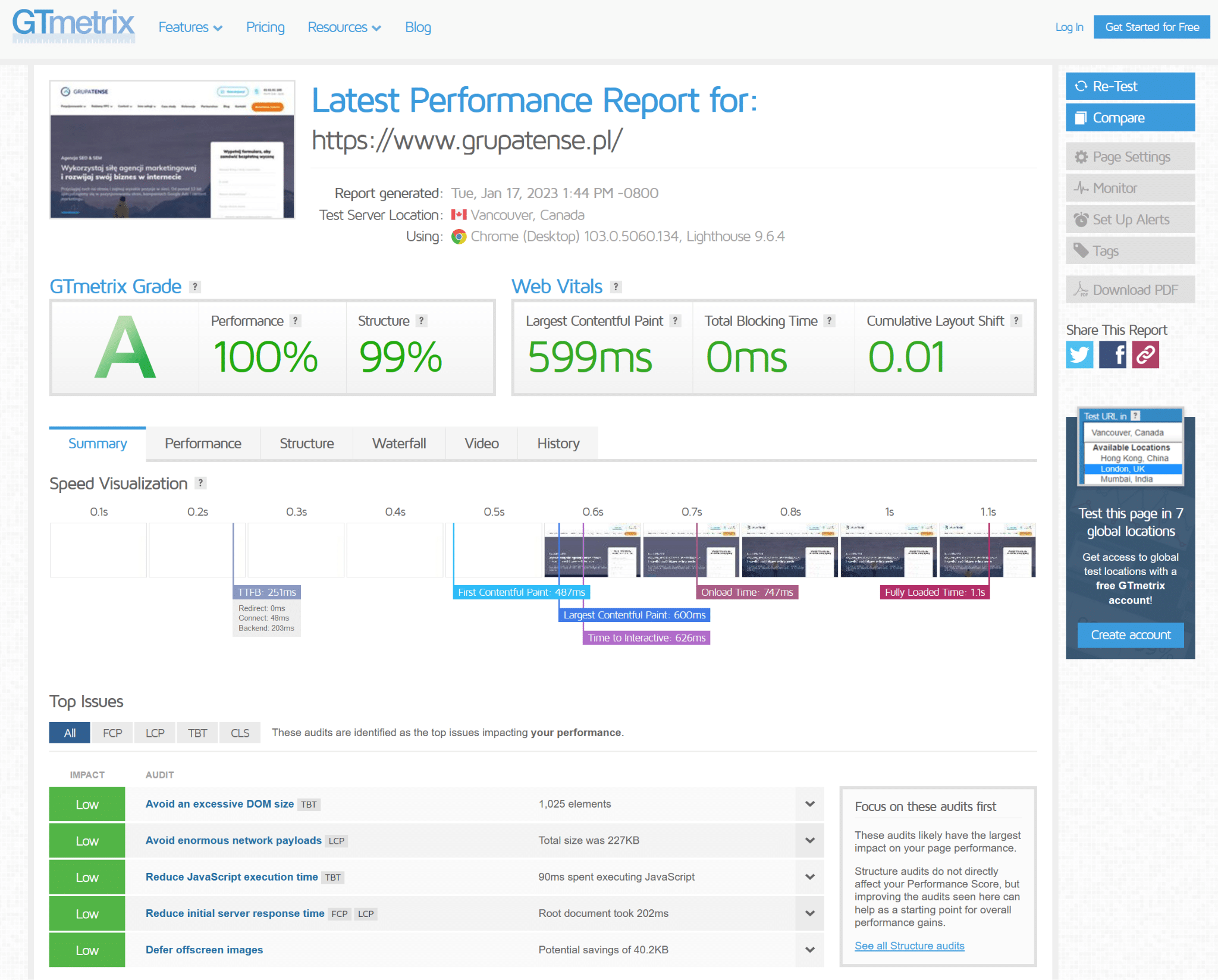

6. Sprawdź wydajność witryny

Wydajność witryny jest silnym czynnikiem rankingowym dla Google. Jeżeli Twoja witryna długo się ładuje, ma znacznie mniejsze szanse na znalezienie się w topie wyników wyszukiwania. Przy użyciu narzędzi do analizy wydajności serwisu, takich jak GTMetrix lub Google PageSpeed Insights, łatwo dowiesz się, jakie są największe problemy wydajnościowe Twojego serwisu oraz na co należy zwrócić największą uwagę. Dostarczają one także zalecenia i wskazówki dotyczące optymalizacji wydajnościowej. Nawet jeżeli uważasz, że Twoja strona już jest szybka i nie potrzebuje dodatkowej optymalizacji, rekomenduję korzystanie z tych narzędzi, gdyż zawsze znajdzie się coś, co można ulepszyć. Wiele elementów wydajnościowych, takich jak: minimalizacja kodu, optymalizacja obrazów, wykorzystanie pamięci podręcznej i kompresja zasobów, ma wpływ na ranking witryny.

Źródło: GTMetrix

7. Sprawdź dostosowanie do urządzeń mobilnych

Od kilku dobrych lat Google praktykuje podejście mobile first. Oznacza to, że skanując serwisy, boty Google przede wszystkim skupiają się na wydajności i dostosowania strony do urządzeń mobilnych. Jest to mocnym czynnikiem rankingowym, dlatego upewnij się, czy Twoja witryna jest dostosowana do urządzeń mobilnych. Zrobić to można za pomocą narzędzia Mobile-Friendly Test od Google. Brak dostosowania do mobile skutkuje dużymi konsekwencjami dla widoczności. Jeśli Twoja witryna nie zostanie uznana za przyjazną dla urządzeń mobilnych, narzędzie przedstawi komplet zaleceń, po których wdrożeniu zaliczysz test i polepszyć indeksację serwisu.

8. Sprawdź profil linków zewnętrznych

Linki zwrotne służą do informowania wyszukiwarki, że Twoja witryna jest popularna i ma renomę, a więc prawdopodobnie będzie odpowiednia dla użytkowników. Mimo że linki mają coraz mniejsze znaczenie dla Google w kontekście czynników rankingowych, jest to wciąż kwestia istotna, kiedy mówimy o skutkach linkowania nienaturalnego bądź spamerskiego. Z różnych powodów – czasami celowo (kupując tanie linki), a czasami nie mając na to wpływu – profil linkowy domeny może zawierać dużo „podejrzanych” linków bądź linków przeważnie jednego typu, co w konsekwencji źle wpływa na postrzeganie witryny przez Google. W przypadku odnotowania istotnych spadków witryny polecam przeprowadzić analizę linkowania zewnętrznego za pomocą popularnych narzędzi, takich jak Ahrefs lub Majestic. Dzięki temu możesz dowiedzieć się, czy nie ma żadnych problemów z linkowaniem, albo odkryć, że profil linków jest słabej jakości i zgłosić słabe linki do zrzeczenia się dla Google.

9. Sprawdź treść na stronie

W marketingu istnieje bardzo popularne powiedzenie: „content is the king”, czyli treść jest najważniejsza. Rzeczywiście, jakość treści nigdy nie była ważniejsza dla wyszukiwarek niż teraz. W praktyce oznacza to, że duża liczba duplikatów i powielanie treści na serwisie bardzo negatywnie wpływają na jej indeksację. Upewnij się, czy content na serwisie jest interesujący i angażujący oraz czy zawiera obrazy, wideo i inne elementy visual marketingu. Oprócz tego pamiętaj, że treść nie może być przesycona słowami kluczowymi, bo wtedy będzie uznana za mało wartościową i spamerską.

Jakość treści ma duży wpływ na pozycje. I chociaż wartość treści jest pojęciem w dużym stopniu subiektywnym, istnieje kilka wskaźników i narzędzi, do których można się odnieść przy jej tworzeniu lub analizowaniu.

- Czas spędzony na stronie. Jeżeli użytkownicy szybko opuszczają stronę, może to być sygnałem, że treść w określonej podstronie jest niskiej jakości i nie angażuje odbiorców.

- Analiza unikalności treści. Narzędzia, takie jak Siteliner są pomocne w kontekście identyfikacji duplikatów w treści oraz określenia, jaki odsetek treści na serwisie jest w pełni unikatowy.

- Analiza data-driven. Przy pomocy narzędzi takich jak Surfer SEO ocenisz, w jakim stopniu treść ma poprawną strukturę nagłówków, jaka długość tekstu jest zalecana, jakich fraz kluczowych brakuje albo jest za dużo w tekście oraz wiele innych rzeczy.

Dzięki temu możesz znacząco podnieść jakość treści w Twojej witrynie, co pozytywnie wpłynie na jej widoczność.

10. Sprawdź słowa kluczowe serwisu

Źle dobrane bądź za trudne słowa kluczowe nie przyniosą dla serwisu żadnych korzyści i z dużym prawdopodobieństwem przyczynią się do spadków na serwisie. Osadzone w treści mogą przynieść tymczasowe efekty, ale ostatecznie po jakimś czasie spowodują spadek widoczności z uwagi na:

- brak spójnej tematyczności słów kluczowych i witryny,

- duży współczynnik odrzuceń,

- niską konwersję,

- konkurencyjne serwisy.

Co więcej, słowa kluczowe dobrane kilka lat temu dzisiaj mogą już być nieaktualne. Dlatego raz na jakiś czas należy przeglądać listę fraz, na które widoczny jest serwis, oraz dobierać nowe poprzez przeprowadzanie analizy słów kluczowych. Brak aktywności w zakresie analizowania i dobierania nowych słów kluczowych grozi stagnacją i następnie spadkami widoczności. Tak samo ważne jest pozbywanie się słów kluczowych, które są nierealne do osiągnięcia bądź nie niosą żadnych korzyści. To pozwoli na skupienie większej uwagi dla wartościowych fraz przy optymalizacjach.

Podsumowanie – co zrobić, gdy spadają pozycje

Jak powiedział kiedyś mój szef, „najpierw trzeba sprawdzić, czy strona działa”. Jeżeli działa, postępuj metodycznie i zachowuj chłodny umysł, a na pewno uda się znaleźć sedno problemu i odbudować utraconą widoczność.

Skontaktuj się z nami!

Wypełnij formularz

Przygotujemy dla Ciebie bezpłatną wycenę!

Dodatkowo otrzymasz bezpłatnie dostęp do kursów z marketingu internetowego.