Jakie techniki należą do BHS?

W branży SEO istnieją dwa główne podejścia do procesu pozycjonowania. Dzielimy je na White Hat SEO (WHS) oraz Black Hat SEO (BHS). Pierwsze z nich jest w pełni zgodne z Wytycznymi Google dla Webmasterów, drugie natomiast określa się mianem niewskazanego, zwłaszcza w przypadku, gdy zależy nam na długofalowym efekcie.

Działania BHS mogą doprowadzić do sankcji Google – jest to kara ręczna nałożona przez Ratera lub filtr algorytmiczny. O ile w przypadku pierwszej kary zostaniemy o niej poinformowani, jak i nawet wskazane zostanie nam jej źródło, tak w drugim przypadku nie otrzymamy oficjalnego potwierdzenia. Założenie filtra na naszą stronę może spowodować spadek ruchu i pozycji strony w wynikach wyszukiwania na konkretne wyrażenie lub na ich grupę, a nawet wszystkie wyrażenia. Stosowanie technik Black Hat może również doprowadzić do usunięcia strony z indeksu, braku indeksowania przez roboty poszczególnych podstron, a także utraty wartości PageRank.

Poniżej postaram się przestawić oraz opisać, dlaczego niektóre z działań nad stroną w procesie pozycjonowania mogą zostać odebrane jako niewskazane.

Cloacking (maskowanie)

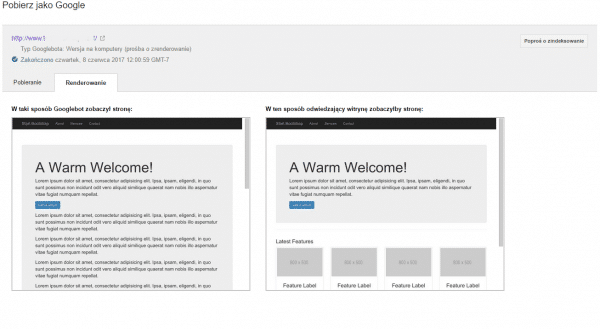

Polega na przedstawianiu innych treści, struktury czy adresów URL robotom wyszukiwarki niż te, które widzi użytkownik odwiedzający stronę. Przykładem takiego maskowania może być np. wyświetlanie użytkownikom animacji flash lub złożonej z samych obrazków, a robotom tylko treści.

Cloackingiem jest również wyświetlanie dodatkowych tekstów lub słów kluczowych w przypadku, gdy klient użytkownika przedstawia się jako robot wyszukiwarki.

Poniżej prezentujemy oficjalne materiały Google na temat maskowania, przedstawione w formie wideo prezentacji przez Matta Cuttsa:

Keyword Stuffing

Czyli innymi słowy „upychanie słów kluczowych”, polegające na zapełnianiu strony internetowej słowami kluczowymi w nienaturalny sposób, w celu poprawienia pozycji witryny na konkretne wyrażenia. Często pojawiają się w formie listy, wymienione po przecinku zupełnie bez związku z treścią (z reguły w stopkach, sidebarach lub innych miejscach strony). Oprócz słów kluczowych pod Keyword Stuffing kwalifikuje się także: umieszczanie bloku tekstu z listami miast i województw, wypisywanie listy numerów bez związku z treścią oraz częste występowanie tych samych słów lub wyrażeń w tekście.

Thin content

Thin content to głównie sztucznie generowane strony bez wartości dla użytkownika, które nienaturalnie zwiększają site domeny, czyli liczbę aktualnie zaindeksowanych stron przez robota wyszukiwarki. Takie strony często zawierają bardzo dużo słów kluczowych, ale nie posiadają wartościowych, pełnych tekstów (np. na stronie znajduje się jedno zdanie, a w stopce lub sidebarze wymienione są po przecinku słowa kluczowe) lub są one skopiowane z innego serwisu, a więc są bez wartości dla użytkownika. Wszystkie strony, które nie posiadają żadnej wartości, mogą zostać odebrane jako próba manipulacji rankingiem.

Teksty powinny nieść jak największą wartość dla użytkownika, muszą być eksperckie i wyczerpywać tematykę oraz zawierać naturalne wystąpienia wyrażeń kluczowych.

Treści generowane automatycznie

Treści wygenerowane przez narzędzie są nienaturalne i mocno nasycone słowami kluczowymi, a ich głównym celem jest wpływ na ranking. Algorytmy Google są coraz bardziej precyzyjne, dlatego nauczyły się znajdować schematy i rozpoznawać takie treści. Poniżej przykłady:

- „tekst przetłumaczony przez zautomatyzowane narzędzia i opublikowany bez wcześniejszego sprawdzenia przez człowieka;

- tekst wygenerowany przy użyciu automatycznych procesów, np. łańcuchów Markowa;

- tekst wygenerowany przy użyciu technik automatycznego dobierania synonimów lub przetwarzania;

- tekst wygenerowany przez kopiowanie treści kanałów Atom/RSS lub wyników wyszukiwania;

- łączenie zawartości innych stron internetowych bez dodawania wystarczającej ilości treści ani dodatkowych funkcji.”

Źródło cytatu: Search Console – Pomoc: Treści generowane automatycznie

Ukrywanie treści i elementów w kodzie

Ukrywanie linków, treści lub innych elementów w kodzie witryny w celu manipulowania rankingiem jest odbierane jako działania BHS. Przez ukrywanie rozumie się:

- stosowanie białego tekstu na białym tle,

- umieszczanie tekstu pod obrazem, elementem blokowym HTML,

- umieszczanie tekstów poza ekranem przez manipulacje marginesami w stylach CSS,

- ukrywanie linków przez bardzo małe teksty zakotwiczenia.

Systemy wymiany linków

Choć w Polsce systemy wymiany linków są jeszcze popularne, ich stosowanie za granicą jest już praktycznie zerowe i bardzo ryzykowne. Przekonali się o tym nasi zachodni sąsiedzi, gdy wszystkie strony bazujące na SWL otrzymały sankcje, a wraz z nimi serwisy oferujące systemy wymiany oraz oferowane przez nich zaplecza.

Google do kategoryzacji linków pochodzących z systemów wymiany podchodzi bardzo ogólnie, ponieważ za takie odnośniki uważa wszystkie, które mogą wpływać na pozycję w wynikach oraz PageRank domeny. Do samego systemu wymiany linków zaliczamy:

- kupowanie lub sprzedawanie linków,

- wymianę na dużą skalę w formie „udostępnij mój link, a ja udostępnię twój”,

- dużą liczbę artykułów sponsorowanych,

- artykuły gościnne w innych serwisach, posiadające dużą liczbę wyrażeń w tekście zakotwiczenia,

- automatyzację w tworzeniu/pozyskiwaniu linków.

Niejawne przekierowania

Choć samo Google otwarcie zachęca do używania przekierowań, należy jednak być ostrożnym i stosować je tylko w uzasadnionych przypadkach, takich jak zmiana domeny, zmiana adresu URL podstrony czy łączenie wielu stron w jedną.

Stosowanie przekierowań, które mogą wpłynąć na ranking strony, zostanie odebrane negatywnie. Mowa tutaj o przypadku, gdy robot pod żądanym adresem widzi zawartość strony, a użytkownik zostaje przekierowany na zupełnie inną podstronę.

Za przekierowanie niejawne uważane jest również stosowanie takiego przekierowania dla użytkowników urządzeń mobilnych, gdzie w przeciwieństwie do użytkowników wersji desktop, występuje przejście do domeny zawierającej spam.

DoorwayPages

Inaczej strony przejściowe, czyli stworzone w celu zajmowania wysokich pozycji w wynikach wyszukiwania i prowadzące do zupełnie innych stron. Tego typu witryn może występować więcej, mogą one prowadzić do stron pośrednich, które nie są tak przydatne jak strona docelowa.

Przykładami stron przejściowych są:

- używanie wielu nazw domenowych i przekierowanie ich na jeden serwis,

- strony ukierunkowane na określone regiony lub miasta prowadzące użytkowników do jednego serwisu,

- strony utworzone po to, aby prowadzić do użytecznych lub istotnych dla właściciela części witryn,

- podobne do siebie strony, zbliżone wynikami wyszukiwania.

Tworzenie złośliwych stron (wyłudzanie informacji)

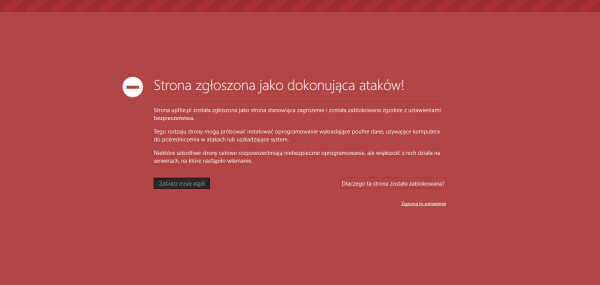

Jeśli oprogramowanie strony działa w niewłaściwy sposób, przez który rozumie się manipulowanie jej zawartością, pobieranie plików na komputer użytkownika i ich uruchamianie bez jego wiedzy – tego typu działania będą odbierane jako niezgodne z wytycznymi Google dla Webmasterów. W przypadku ich wykrycia naszym oczom pojawi się następujący komunikat:

Poniżej lista oficjalnych przykładów z pomocy Google:

- „zmienianie położenia treści na stronie lub manipulowanie nim, tak że gdy użytkownikowi wydaje się, że klika na określony link lub przycisk, kliknięcie jest rejestrowane przez inną część strony;

- wstawianie na stronach nowych reklam lub wyskakujących okienek, a także zamienianie istniejących reklam na inne lub promowanie bądź instalowanie oprogramowania, które działa w taki sposób;

- dołączanie niepożądanych plików do danych, które chce pobrać użytkownik;

- instalowanie złośliwego oprogramowania, trojanów, programów szpiegowskich, reklam lub wirusów na komputerze użytkownika;

- zmienianie strony głównej przeglądarki użytkownika lub ustawień wyszukiwania bez jego zgody”

Nadużywanie znaczników rozszerzonych

Jest to jeden z nowszych punktów w wytycznych, ponieważ same znaczniki zyskały większą popularność stosunkowo niedawno. Znaczniki te mają na celu ułatwić robotom rozpoznanie konkretnych elementów strony poprzez umieszczenie odpowiednich znaczników na poszczególnych kontenerach. Przez nadużywanie Google ma na myśli:

- oznaczanie tych samych elementów różnymi znacznikami (sugerowane jest stosowanie ich rozdzielnie),

- oznaczanie ukrytych przed użytkownikiem elementów.

Wysyłanie zautomatyzowanych zapytań do Google

Google nie przewiduje wykonywania zautomatyzowanych zapytań, czyli przesyłania zapytań bez zgody. Wysyłanie takich zapytań jest niezgodne, ponieważ absorbuje system i wykonywane jest przez zewnętrzne oprogramowanie, a nie silnik wyszukiwarki.

Do grupy tych zapytań należą wszystkie zapytania, które na celu mają weryfikację, jak dana strona lub witryna wypada w wynikach wyszukiwania, czyli: sztuczne pingowanie, wymuszenia zaindeksowania strony przez robota czy nienaturalna próba podbicia współczynnika CTR.

„Hacking SEO”

Jest to element skupiający kilka czynności z powyższej listy. Polega na wstrzyknięciu szkodliwego oprogramowania przez luki bezpieczeństwa w polarnych systemach CMS, które tworzy sztuczne strony przekierowane na inny serwis.

Google stara się przeciwdziałać tego typu atakom, dlatego od niedawna – jeśli Twoja domena jest zweryfikowana w narzędziu Search Console i korzystasz z jednego z popularnych CMSów np. WordPress lub Joomla – otrzymasz wiadomość o konieczności aktualizacji.

Spam użytkowników

Jedną z oficjalnych wskazówek od Google jest moderowanie działań użytkowników, a szczególnie treści przez nich umieszczanych. Mowa tutaj w szczególności o wpisach na forach oraz komentarzach, które mogą zawierać linki z zakotwiczeniem na frazę do innych stron. Pod tym adresem dostępnych jest kilka porad na temat nadużywania publicznych części swojej witryny. Zawartość jest również przydatna w celu podjęcia działań po otrzymaniu kary ręcznej za spam we witrynie.

Czy moją stronę da się uratować po BHS?

Odpowiedź na to pytanie nie jest jednoznaczna, ponieważ do każdego przypadku należy podejść indywidualnie. Na pewno jest to łatwiejsze, gdy chodzi o zmiany związane ze stroną oraz o otrzymanie kary ręcznej. To jasny sygnał, co jest niezgodne z wytycznymi na stronie. Na wdrożenie zmian poświęcimy kilka dni, a po pozytywnym rozpatrzeniu otrzymamy również wiadomość zwrotną. W przypadku negatywnej odpowiedzi należy wprowadzać zmiany do skutku.

Sytuacja wygląda gorzej w razie otrzymania filtru algorytmicznego – nigdy nie mamy pewności, że taki został nałożony ani z jakiego powodu. Pozostaje nam jedynie analiza poprzednich działań oraz osiąganych aktualnie pozycji przez stronę i ocena, które z nich mogły wpłynąć negatywnie. W konsekwencji, jeśli mamy taką możliwość, wszystkie działania uznane za nienaturalne powinny zostać usunięte lub powinno się uzyskać możliwe jak najwięcej naturalnych czynników, np. naturalne udostępnienia czy ruch z social media, aby „zatrzeć złe ślady”.

Pamiętaj jednak, że jeśli Twoja strona otrzymała filtr, wyjście z niego będzie bardzo czasochłonne i będzie wymagało dużo pracy. Dlatego czasami ostatnią deską ratunku i możliwością uzyskania szybszego efektu jest zmiana domeny z odcięciem się od historii poprzedniej – ponowne rozpoczęcie wszystkich działań. Jednak w przypadku tej decyzji należy dobrze skalkulować, co jest bardziej opłacalne.

Dlaczego klienci decydują się na Black Hat SEO?

Odpowiedzi na to pytanie z pewnością jest wiele, jednak w mojej ocenie głównie z powodów:

- ceny – działania są tańsze, ponieważ wiele elementów jest zautomatyzowanych (np. SWL),

- szybkiego efektu – w większości przypadków intensyfikacja działań daje efekt szybciej, ale zdecydowanie na krócej,

- braku wizualnych zmian – często działania BHS odbywają się bez jakichkolwiek zmian na stronie lub zmiany wprowadzane są tak, że widzi je tylko robot wyszukiwarki,

- braku konieczności wsparcia po stronie klienta – głównie dotyczy dostarczenia materiałów np. zdjęć lub danych technicznych dla copywritera.

Dlaczego White Hat SEO jest lepsze?

Głównym argumentem, który przemawia za White Hat SEO, jest długofalowy efekt. Ryzyko nagłej straty osiągniętych przez nas efektów tymi metodami jest bardzo niskie. Miejmy jednak na uwadze, że Google z każdą aktualizacją algorytmu dąży do wyeliminowania procesu pozycjonowania, dlatego stosowanie BHS może wkrótce nie przynieść nawet krótkiego, początkowego efektu.